Table of Contents

Bienvenido a TeideHPC#

Visite nuestra web para encontrar más información sobre la infraestructura https://teidehpc.iter.es o envíenos un mail a teidehpc@iter.es.

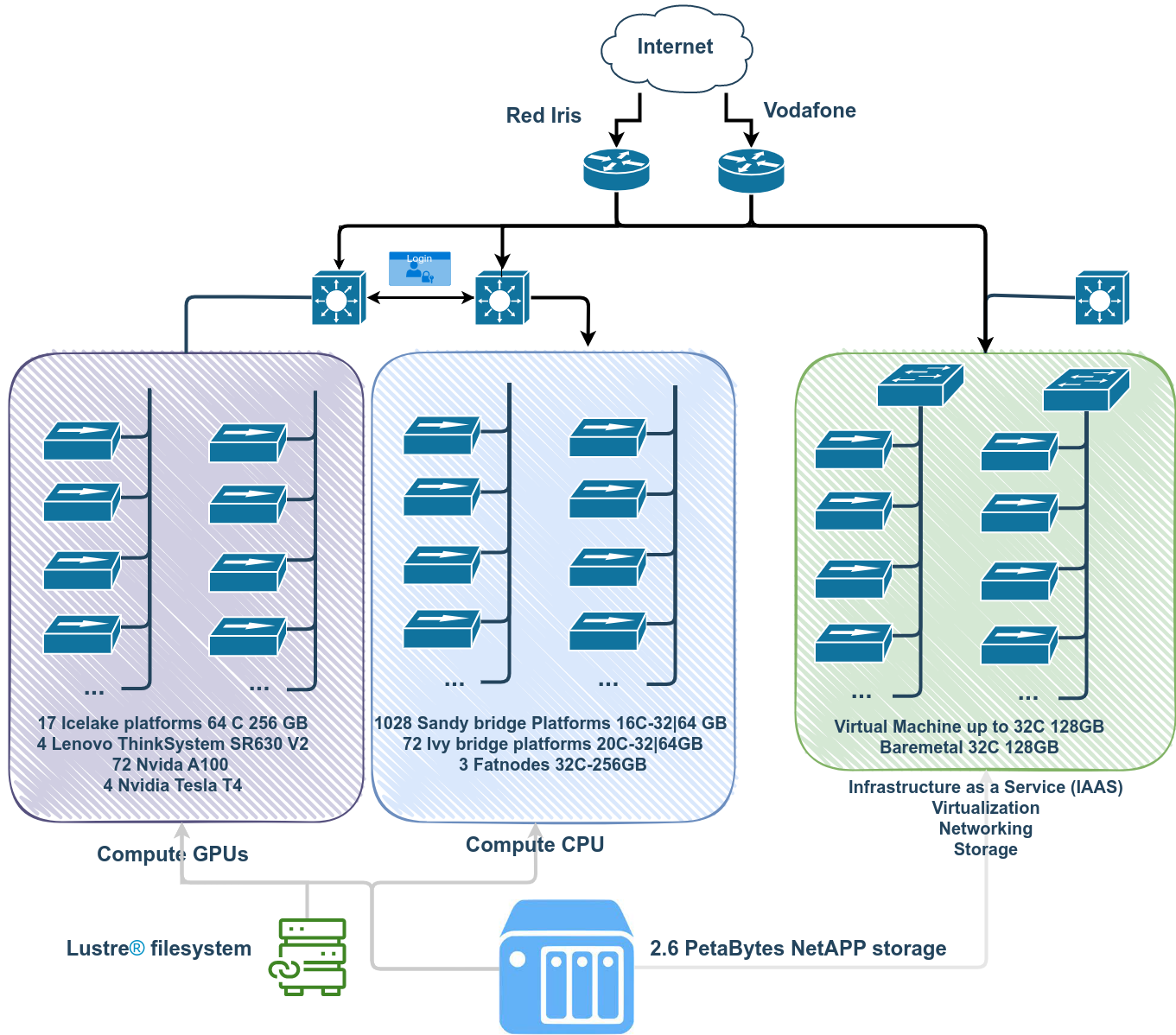

La infraestructura Teide HPC (High Performance Computing) constituye una pieza fundamental del proyecto ALiX para la puesta en marcha de infraestructuras orientadas a la creación de un tejido industrial en torno a las Tecnología de la Información y la Comunicación (TICs) en Tenerife.

El superordenador Teide, es uno de los más potente de España, ofrece a investigadores, empresas del Parque Tecnológico y Científico de Tenerife, y a la Universidad de La Laguna, un medio de alta capacidad de proceso, para mejorar y ampliar el alcance tanto nacional como internacional de las investigaciones. Además está presente en la lista top500 de los supercomputadores más potentes del mundo ocupando el puesto 138 de la lista de noviembre de 2013.

El superordenador Teide es una infraestructura de computación de altas prestaciones de propósito general. Gestionado en el ITER, el superordenador Teide está alojado en datacenter D-ALiX y provisto de infraestructura eléctrica y de frío de alta disponibilidad, y de conectividad a internet de alta velocidad.

Descripción del cluster TeideHPC#

El siguiente diagrama describe de manera muy sencilla cómo está estructurado el cluster.

Nodos de cómputo.#

TeideHPC tiene los siguientes plataformas de cómputo.

| Type | Qantity | Platform | Processors | Cores | Memory | # GPUs |

|---|---|---|---|---|---|---|

| CPU | >500 | Sandy bridge | 2 X Intel Xeon E5-2670 | 16 | 32-64GB | - |

| CPU | 72 | Ivy bridge | 2 X Intel Xeon E5-2670v2 | 20 | 32-64GB | - |

| CPU | 3 | Sandy bridge | 2 X Intel Xeon E5-4620 | 32 | 128-256 GB | - |

| GPU | 16 | Icelake | 2 X Intel Xeon Gold 6338 32C | 64 | 256 GB | 4 Nvidia A100 |

| GPU | 1 | Icelake | 2 X Intel Xeon Gold 6338 32C | 64 | 256 GB | 8 Nvidia A100 |

| GPU | 4 | Icelake | 2 X Intel Xeon Gold 6338 32C | 64 | 256 GB | 8 Nvidia T4 |

Almacenamiento#

-

Almacenamiento NetApp con capacidad de 2.6 Peta Bytes, configurada en formato clúster contando con todos los elementos redundados para hacer frente a posibles fallos de hardware, con discos de spare según las best practices, siendo éstos globales.

-

Almacenamiento paralelo Lustre para aplicaciones que requieran un alto número de operaciones de E/S.

Red#

Teide-HPC dispone de una topología de red donde se definen cuatro redes de propósito específico:

- Red dedicada de almacenamiento.

- Red dedicada de gestión.

- Red out of band.

- Red de baja latencia Infiniband EDR a 100Gbps para cómputo.

Como medidas de seguridad TeideHPC dispone de túneles IPSec, conexiones VPN y la posibilidad de establecer VLANs privadas para sus clientes.

Conectividad#

TeideHPC se conecta a internet a través de la red académica y de investigación española, RedIris, mediante un enlace de 10 Gb. También dispone de conectividad a través del proyecto Alix mediante un operador de internet nacional.

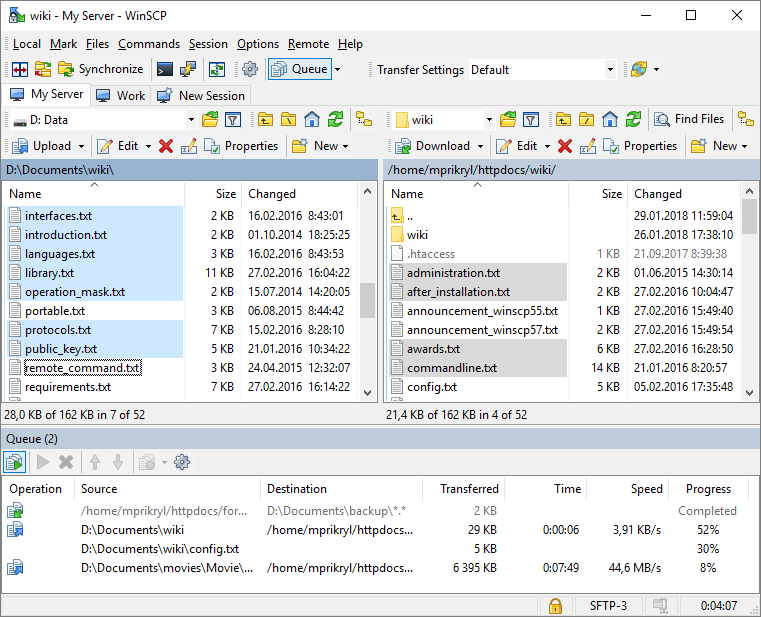

Para realizar transferencias de datos, se dispone de nodos de transferencia que permiten copiar grandes cantidades de datos al espacio de usuario accediendo directamente a la red troncal de datos.

Guías de usuario ↵

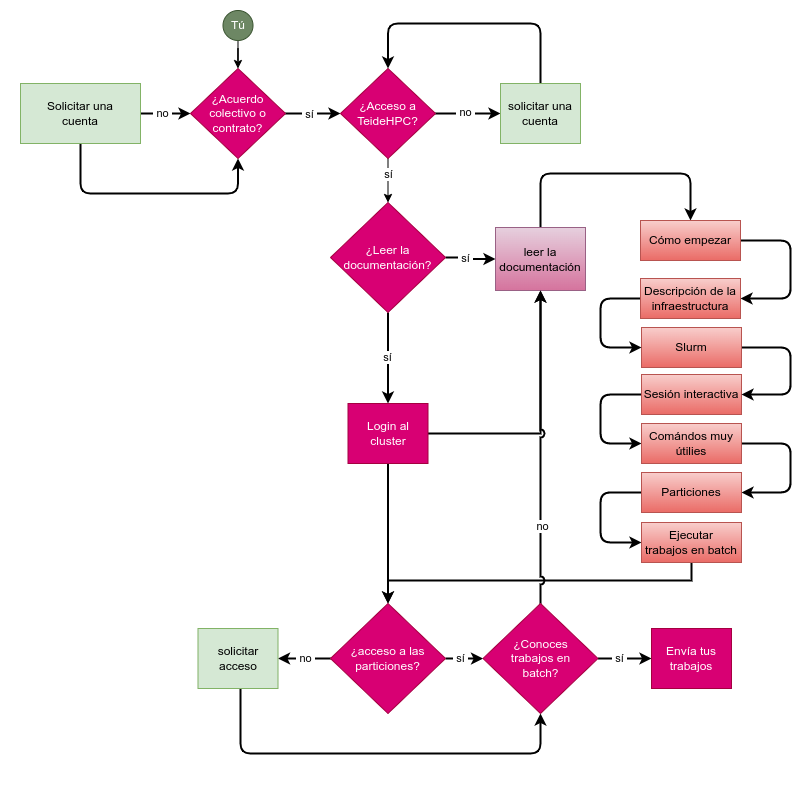

Cómo empezar en TeideHPC#

Esta página lo guiará brevemente a la documentación. Si sigue los pasos a continuación, debería tener una buena idea sobre los aspectos más importantes del clúster TeideHPC.

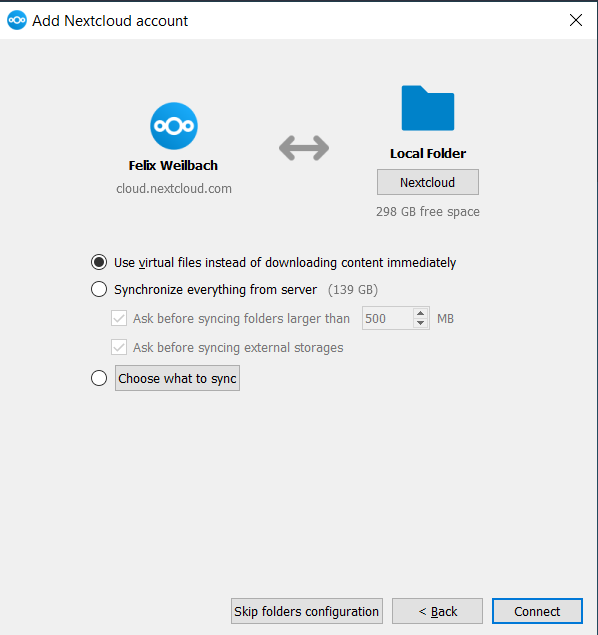

1. Consigue una cuenta TeideHPC.

Si tu entidad tiene firmado un convenio con nosotros, obtén una cuenta TeideHPC enviando un correo electrónico a soporte@hpc.iter.es informándonos quién es el responsable del departamento o entidad a la que perteneces.

Si eres un investigador o una empresa interesada en utilizar nuestros servicios, pregúntanos.

2. Envíanos una clave pública GPG.

Recibirá sus credenciales de VPN cifradas con su clave pública GPG. Sólo necesitará descifrarlas y conectarse a nuestra VPN.

3. Cambie su contraseña de usuario

Después de conectarte por primera vez puede cambiar su contraseña. Éstas tiene una serie de políticas de seguridad que deberá cumplir así como una fecha de caducidad.

4. Antes de comenzar cualquier cálculo serio, eche un vistazo a las opciones de almacenamiento.

¡Tu directorio home en TeideHPC tiene un límite flexible de 5GB! Recomendamos guardar sus datos en el directorio de datos o lustre

5. Descubra la sección de comandos útiles y consejos de uso

Hay bastantes comandos útiles y consejos de uso que pueden facilitar su vida en el clúster.

6. Antes de enviar un trabajo, recomendamos documentarse sobre los siguientes aspectos":

- Descripción del cluster

- Gestor de trabajos Slurm

- Particiones todas las particiones tienen límites de tiempo diferente.

- Cómo se carga el software

- Sesiones interactivas

- Cómo usar las GPU

- Ejecuciones multinodo (MPI)

7. Familiarizarse con los trabajos en batch

Eche un vistazo a la seccíón Cómo ejecutar trabajos en batch

8. ¡No malgastes!. Usa los nodos y las GPU eficientemente.

Estudia la eficiencia de tus trabajos con slurm o indícanos el número de trabajo, hora de inicio y finalización, así como el nombre de los nodos sobre los que se ejecutó y te enviaremos unas gráficas donde podrás ver el rendimiento del mismo.

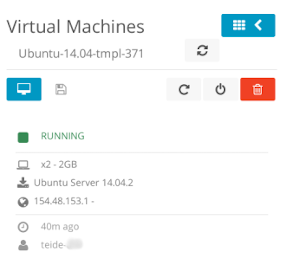

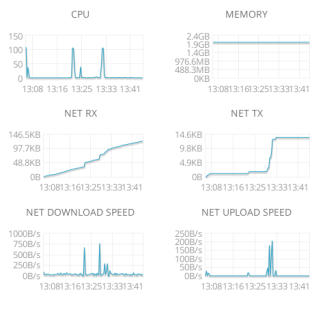

9. ¿Necesita Computación en la nube, IaaS (Infraestructura como servicio), virtualización, almacenamiento, red privada o servidores?

Escríbenos a support@hpc.iter.es

10. Cualquier otra cuestión, ayuda o asesoramiento técnico?

Escríbenos a support@hpc.iter.es

Flujo de trabajo recomendado en TeideHPC.#

Guías de transición ↵

Guía de transición a Rocky 8.#

Con motivo de la llegada de las GPU al centro de supercomputación TeideHPC se ha introducido una versión nueva del sistema operativo que usan tanto los nodos de cómputo, GPU y nodos de login. Todo el cluster relacionado con Centos 6 y Centos 7 estarán al final de vida en pocos meses.

Por otra parte, se ha creado un nuevo cluster llamado AnagaGPU y se han realizado algunos cambios en el cluster TeideHPC, así como en el software, por lo que si ya ha ejecutado trabajos en TeideHPC deberá realizar ajustes en su flujo de trabajo.

Resumiendo, estos son los cambios más significativos a nivel de Sistema Operativo, acceso, software, slurm.

Sistema Operativo y nodos de login#

- Cada cluster (TeideHPC y AnagaGPU) tiene su propia IP de acceso.

- El sistema operativo de ambos cluster y los nuevos nodos es Rocky 8.

- Existen 4 nuevos nodos de login dispuestos en alta disponibilidad (HA) mediante 2 IPs de acceso.

- La asignación de nodo de login durante el acceso es aleatoria y va en función del número de usuarios.

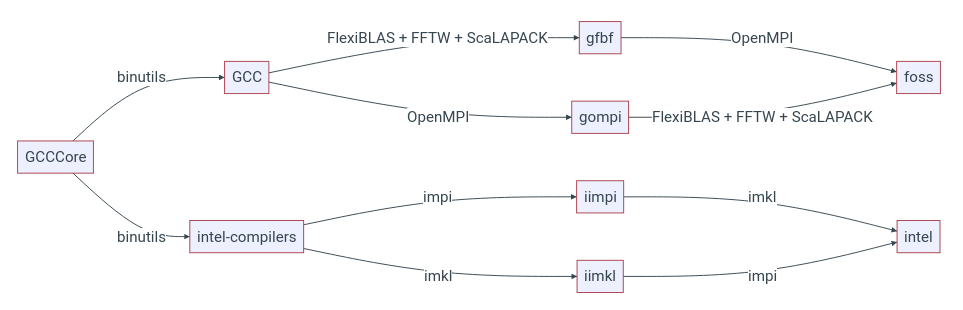

Software#

-

El cambio en el sistema operativo significa que la mayoría del software de los usuarios basado en Centos 6 o CentOS 7 no funcionará y ha de ser recompilado.

-

Se deja de usar la herramienta de modules TCL (Centos 6) en virtud de Lmod.

-

El software instalado pasa a estar organizado mediante una nomenclatura plana

-

Cada tipo de nodos tiene instalado y compilado el software específico para cada arquitectura de nodos. Esto quiere decir:

El software instalado depende de la arquitectura de los nodos

- Básicamente hay 2 arquitecturas: icelake (nodos con GPUs) y sandybrige(nodos de CPU).

- Mira la descripción del cluster en la página principal así cómo la página "Cómo solicitar recursos de GPU y cómputo".

Cada cluster tiene su propio software

Para ver el software disponible en cada cluster debe ingresar a través de las Ip de acceso de cada cluster.

Existen módulos que no dependen de la arquitectura

Slurm#

- La asignación de nodos pasa de ser Modo NO compartido a nodos compartidos.

Esto quiere decir que, al solicitar simplemente 1 nodo de cómputo, no se solicita el nódo completo para el usuario, por lo que se obliga al usuario a realizar una reserva completa de recursos si es lo que se desea.

- Los parámetros por defecto que asigna slurm son:

#SBATCH --node=1

#SBATCH --ntask=1

#SBATCH --ntask-per-node=1

#SBATCH --cpu-per-task=1

#SBATCH --mem=2GB

-

Se ha introducido el uso de una partición nueva para la solicitud de recursos de GPUs.

-

Recomendamos encarecidamente que para ejecutar aplicaciones se use el comando

srun tu_aplicacion. Aquí puedes ver una explicación sencilla de qué implicaciones puede tener usarlo o no usarlo. -

Puedes estudiar la eficiencia de tus trabajos completados con un simple comando.

Repositorio público con ejemplos#

Para facilitar el inicio y acceso a la computación HPC en TeideHPC, hemos creado un repositorio público en github donde iremos publicando ejemplos de uso de aplicaciónes.

Te animamos a colaborar en él. https://github.com/hpciter/user_codes

Ended: Guías de transición

Seguridad y VPN ↵

Claves GPG ↵

¿Qué es GPG?#

GNU Privacy Guard (GnuPG o GPG) es una herramienta de cifrado y firmas digitales que implementa el estándar OpenPGP. GnuGPG permite encriptar y firmar tanto datos como comunicaciones (emails por ejemplo). Cuenta con un sistema de gestión de claves versátil, junto con módulos de acceso para todo tipo de directorios de claves públicas. También conocido como GPG, es una herramienta de línea de comandos con funciones para una fácil integración con otras aplicaciones.

GPG cifra los mensajes usando pares de claves individuales asimétricas generadas por los usuarios. Las claves públicas pueden ser compartidas con otros usuarios de muchas maneras, un ejemplo de ello es depositándolas en los servidores de claves.

NOTA: NUNCA COMPARTA SU CLAVE PRIVADA, GUÁRDELA A BUEN RECAUDO Y SÓLO REMITA O PUBLIQUE EN UN SERVIDOR DE CLAVES LA PÚBLICA.

GPG para usuarios linux#

Todas las distribuciones linux incorporan la aplicación por defecto.

Generar una par de claves (pública y privada)#

Se debe contestar a una serie de preguntas en orden para generar la clave pública y privada:

- Key type. RSA-RSA por defecto.

- Expiration time: Tiempo de validez de la clave.

- User data (Real name, email, comment) . Estos datos son usados para identificar la clave en servidores de claves públicas y/o cuando se le envían a otros usuarios

- Password: Contraseña para proteger la clave privada.

Exportar la clave publica#

Importar una clave publica#

Listar las claves públicas importadas con el siguiente comando:

Encriptar archivos con una clave pública importada#

Desencriptar archivos con la clave privada (si es de nuestra propiedad)#

Otros links utiles sobre gpg#

¿ Qué es GPG ?#

Ver descripción aquí

GPG para usuarios windows#

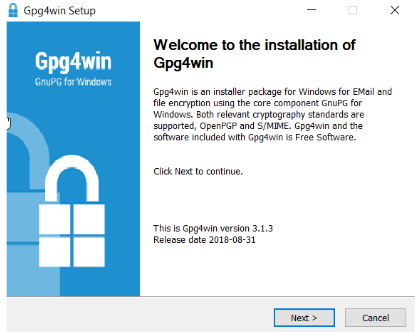

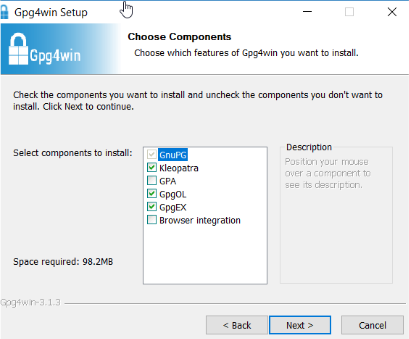

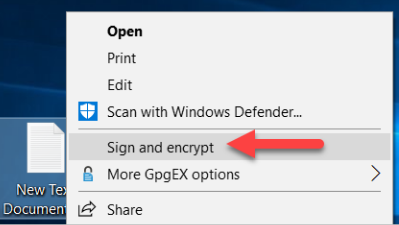

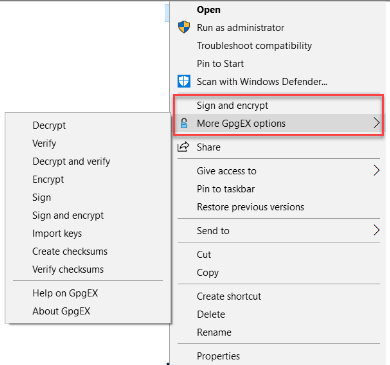

Existen varias aplicaciones bajo el sistema operativo Windows que permiten generar un par de claves gpg. Entre las más conocidas está Gnu4win y su módulo [Kleopatra]. La aplicación Gpg4win es un software de encriptación de libre distribución el cual permite el cifrado de ficheros y el envío de documentos a través del correo electrónico utilizando criptografía de clave pública para el cifrado de datos y firmas digitales.

Soporta los estándares de criptografía OpenPGP y S/MIME (X.509).

Gpg4win se compone varios módulos, entre ellos:

- GnuPG : la herramienta de cifrado básico

- Kleopatra : administrador de certificados para OpenPGP y X.509

- GPA : un administrador de certificados alternativa ( GNU ) para OpenPGP y X.509

Instalación de GPG4win#

En la web del proyecto descargar la versión más reciente del software. Abrir el instalador y autorizar los cambios en caso necesario. Seguir los pasos indicados con el botón Siguiente.

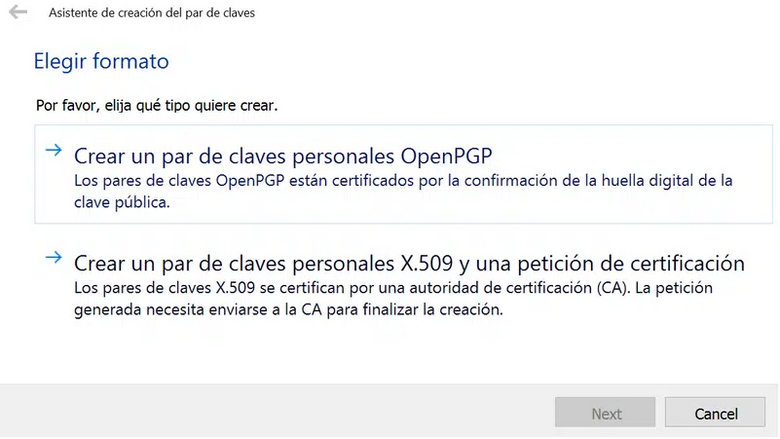

Generar una par de claves (pública y privada)#

Una vez instalado Gpg4win vamos a utilizar el módulo Kleopatra para generar un nuevo par de claves gpg. Para ello desde la pestaña Archivo seleccionamos Nuevo Certificado, lo cual abrirá el asistente de generación de certificados.

Pulsa en Nuevo par de claves GPG

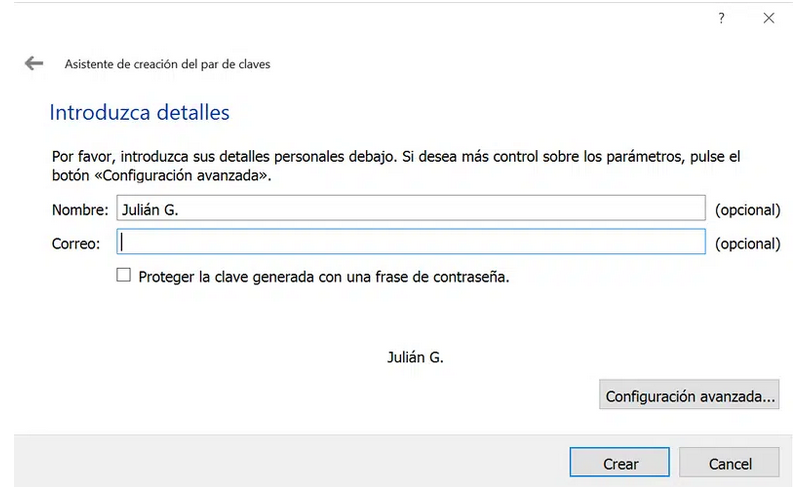

Introducir los datos requeridos

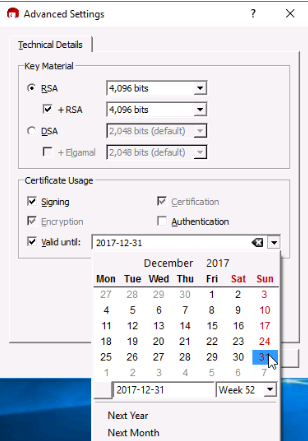

En la pestaña Avanzadas indicar una longitud de clave de 4096 bits y una fecha de caducidad en el desplegable inferior no superior a 2 años.

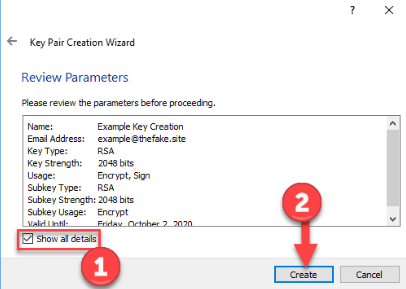

Confirmar los valores introducidos y generar las claves pulsando en Crear.

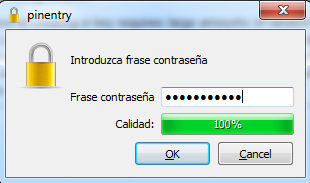

Introducir una contraseña que recuerde para su clave privada. Esta contraseña será la que deba usar para descrifrar los archivos que reciba cifrados con su clave pública.

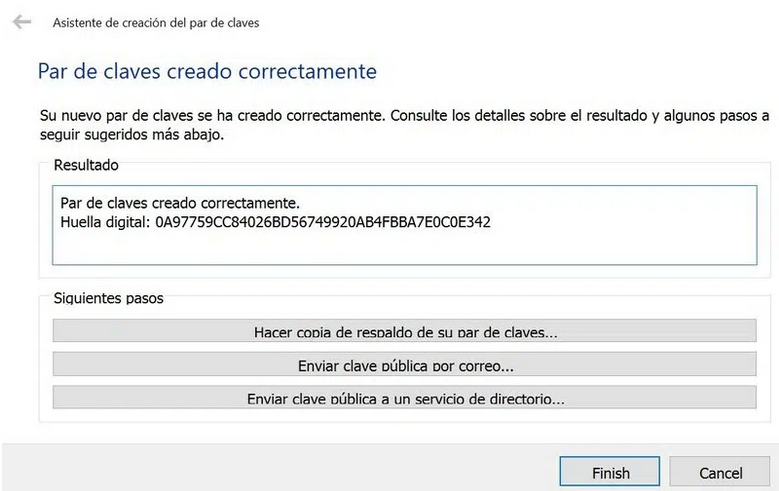

Al pulsar OK verá que su par de claves pública/privadas se han generado correctamente

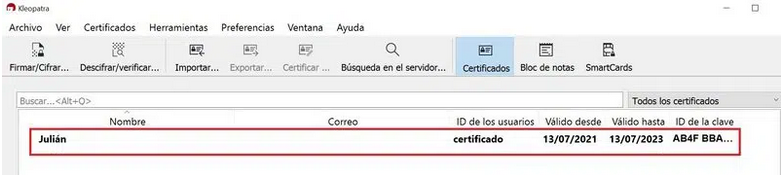

Se puede comprobar que se han creado con éxito el par de claves en la pestaña Certificados.

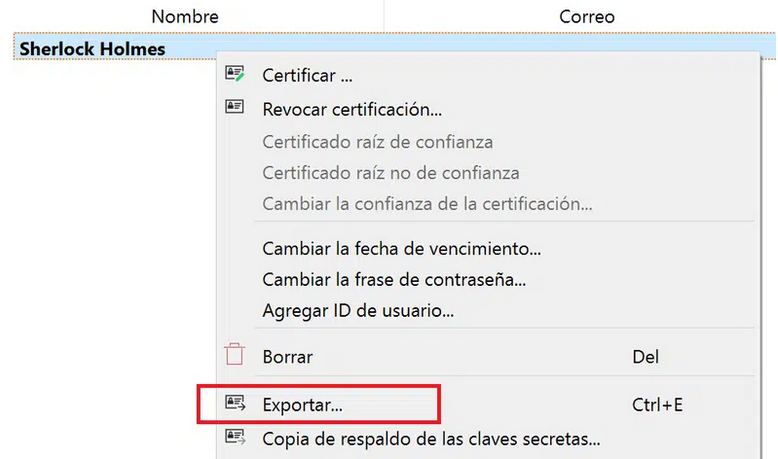

Exportar la clave pública#

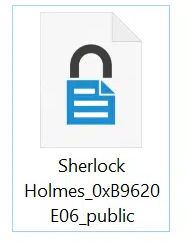

Al exportar la clave pública se genera un fichero de texto que por norma general se almacena con la extensión .asc, que es el que podrá distribuir por correo electrónico o bien publicar en un servidor de claves públicas como REDIRIS y donde cualquier persona la puede descargar.

Obtendrá un fichero de este tipo:

Cifrar ficheros con la clave pública.#

Descifrar ficheros con la clave privada#

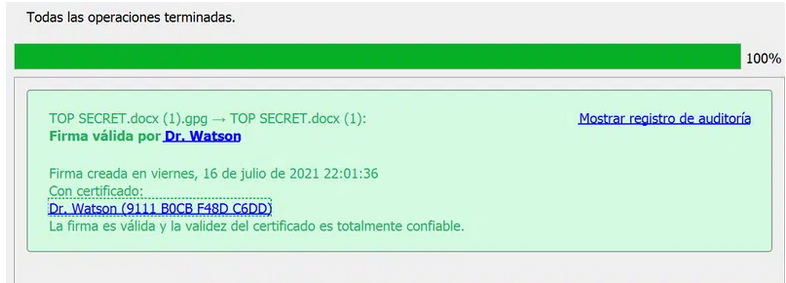

Sólo si un archivo .gpg ha sido cifrado con su clave pública y tiene la clave privada, así como su contraseña, podrá descifrar su contenido.

Se puede usar el menú contextual Descifrar y verificar para recuperar el fichero original pulsando con el segundo botón. También es posible realizar esto desde Kleopatra.

Una vez desencriptado este tendrá el mismo nombre sin la extensión gpg.

NOTA IMPORTANTE: Si cambia de ordenador o usa uno diferente asegurese de tener su par de claves a buen recaudo. Sin ellas no tendrá la posibilidad de descrifrar el contenido del archivo. Por ello recomendamos realizar un backup del par de claves GPG

¿Qué es GPG?#

GNU Privacy Guard (GnuPG o GPG) es una herramienta de cifrado y firmas digitales que implementa el estándar OpenPGP. GnuGPG permite encriptar y firmar tanto datos como comunicaciones (emails por ejemplo). Cuenta con un sistema de gestión de claves versátil, junto con módulos de acceso para todo tipo de directorios de claves públicas. También conocido como GPG, es una herramienta de línea de comandos con funciones para una fácil integración con otras aplicaciones.

GPG cifra los mensajes usando pares de claves individuales asimétricas generadas por los usuarios. Las claves públicas pueden ser compartidas con otros usuarios de muchas maneras, un ejemplo de ello es depositándolas en los servidores de claves.

NOTA: NUNCA COMPARTA SU CLAVE PRIVADA, GUÁRDELA A BUEN RECAUDO Y SÓLO REMITA O PUBLIQUE EN UN SERVIDOR DE CLAVES LA PÚBLICA.

GPG para usuarios de macOS#

A la hora de instalar gpg en macOS tenemos dos formas:

- Instalar la GPG Suite

- Instalar GPG utilizando el gestor de paquetes Homebrew

Recomendamos instalar gpg a través de Homebrew y utilizarlo a través de la terminal, como por ejemplo, iTerm.

Generar una par de claves (pública y privada)#

Se debe contestar a una serie de preguntas en orden para generar la clave pública y privada:

- Key type. RSA-RSA por defecto.

- Expiration time: Tiempo de validez de la clave.

- User data (Real name, email, comment) . Estos datos son usados para identificar la clave en servidores de claves públicas y/o cuando se le envían a otros usuarios

- Password: Contraseña para proteger la clave privada.

Exportar la clave publica#

Importar una clave publica#

Listar las claves públicas importadas con el siguiente comando:

Encriptar archivos con una clave pública importada#

Desencriptar archivos con la clave privada (si es de nuestra propiedad)#

Otros links utiles sobre gpg#

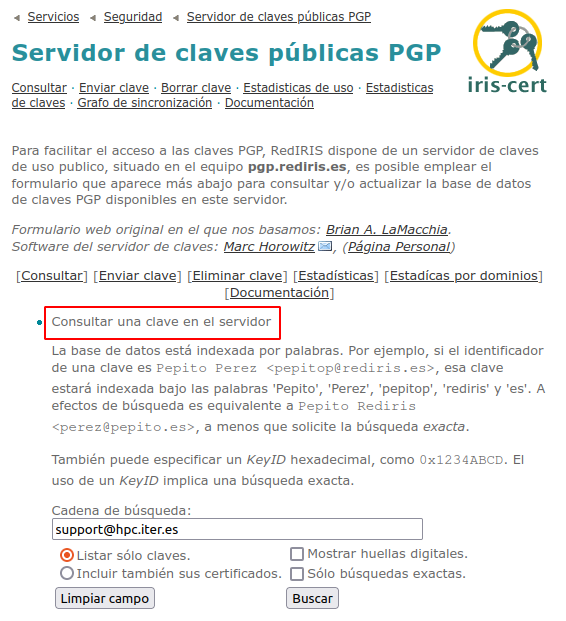

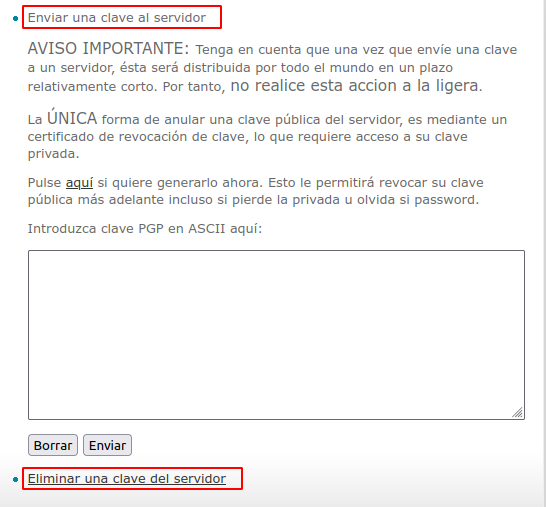

Publicar una clave GPG en un servidor público#

Como se comentaba en apartados anteriores es posible publicar la clave pública en servidores de claves GPG que facilitan el acceso a ellas.

Entre los más conocidos está el servidor de la Rediris.

Este servidor permite tanto consultar claves públicas gpg como publicar las nuestras, así como revocarlas. Estas claves estarán vigentes durante el tiempo que haya dispuesto al generarlas.

Ended: Claves GPG

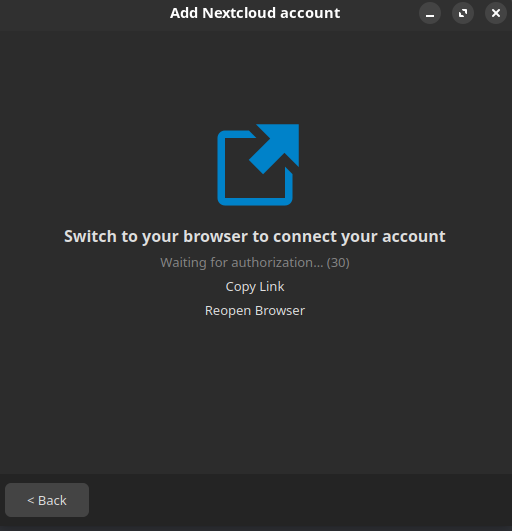

OpenVPN ↵

OpenVPN para usuarios Linux#

Con el fin de proporcionar un acceso seguro a la infraestructura de TeideHPC todas las comunicaciones serán mediante una red privada virtual (VPN).

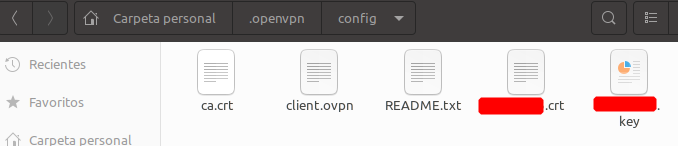

Los usuarios recibirán en su momento un email con los ficheros de configuración y las credenciales de acceso cifrados con su cláve pública GPG.

El contenido del mismo es el siguiente:

- Cuatro ficheros que contienen los certificados del cliente.

- Un fichero client.ovpn que contiene los datos de conexión

- Un fichero README.txt con las credenciales de acceso.

Recordamos que las credenciales VPN tienen carácter personal e intransferible y que solo se permite una única conexión simultánea por VPN.

La mayoría de distribuciones actuales de linux traen instalado un cliente de openVPN por defecto. Éste es posible usarlo mediante terminal o bien configurarlo y usarlo mediante interfaz gráfica.

Cómo primer paso descifre y posteriormente descomprima el fichero gpg que se le adjuntó y colóquelo en una carpeta dentro de su /home.

Conexión mediante terminal#

Para conectarse a la VPN sólo tiene que ir a la ruta ~suhome/.openvpn/su_configuración/ y ejecutar:

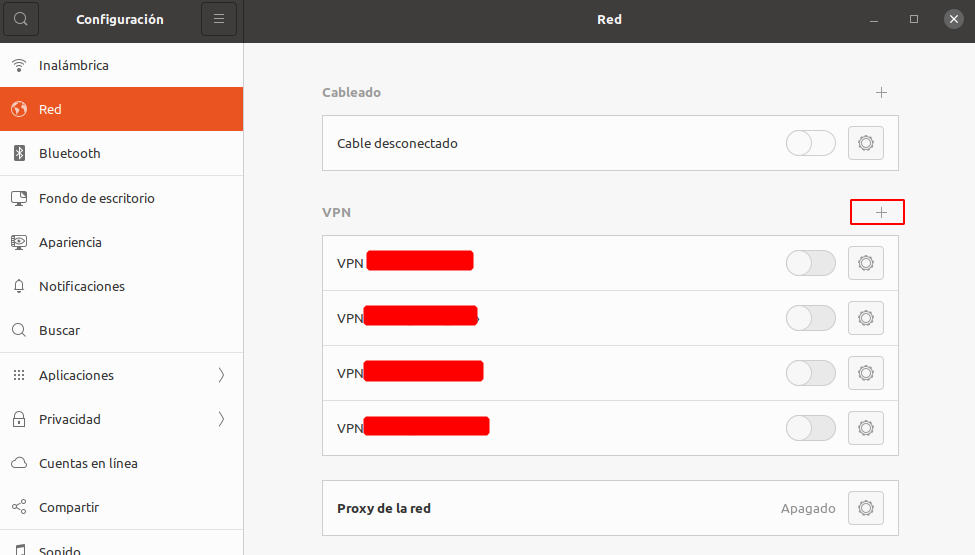

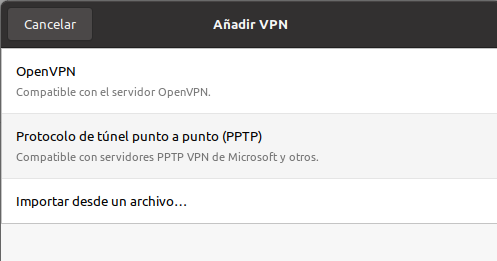

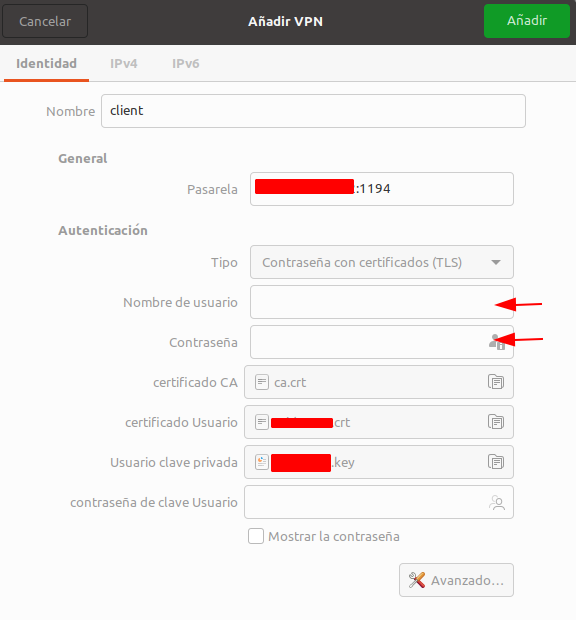

Conexión mediante interfaz gráfica#

Mostramos a continuación una pequeña guía para la distribución Ubuntu 20.04.

Abra el gestor de redes mediante el acceso en la barra de escritorio o bien teclear en el menú de aplicaciónes Configuración.

Abrimos la configuración de Red y agregamos una nueva conexión VPN:

Importamos la configuración desde un archivo

Introducimos nuestro usuario y contraseña

Guardamos la configuración y ya podemos probar a conectarnos a la VPN de TeideHPC.

OpenVPN para usuarios Windows#

Con el fin de proporcionar un acceso seguro a la infraestructura de TeideHPC todas las comunicaciones serán mediante una red privada virtual (VPN).

Los usuarios recibirán en su momento un email con los ficheros de configuración y las credenciales de acceso cifrados con su cláve pública GPG.

El contenido del mismo es el siguiente:

- 4 ficheros que contienen los certificados del cliente.

- 1 fichero client.ovpn que contiene los datos de conexión

- 1 fichero README.txt con las credenciales de acceso.

Recordamos que las claves y ficheros de acceso a la VPN y el usuario y contraseña son personales e intransferibles y sólo permite una conexión simultánea.

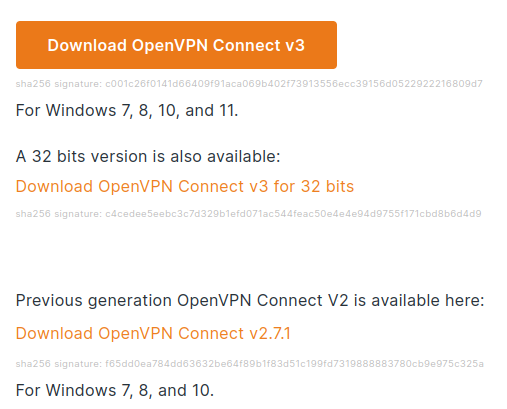

Descarga e instalación#

Aunque Windows 10 y Windows 11 dispone de un cliente VPN propio que podría usarse, recomendamos OpenVPN en su versión 3.

Descargar el cliente OpenVPN en el siguiente link.

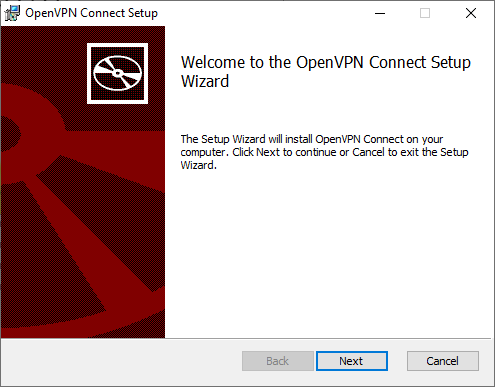

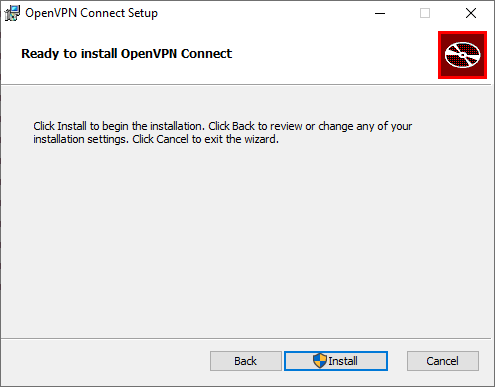

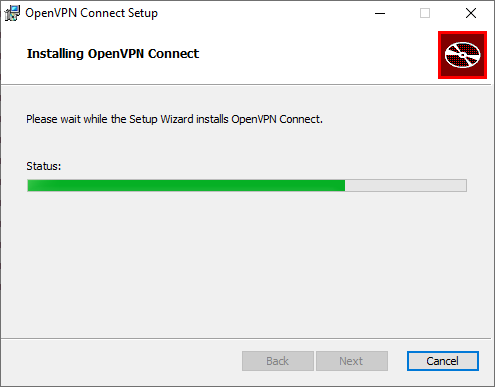

Ejecutar el archivo descargado y le saldrá el asistente de instalación

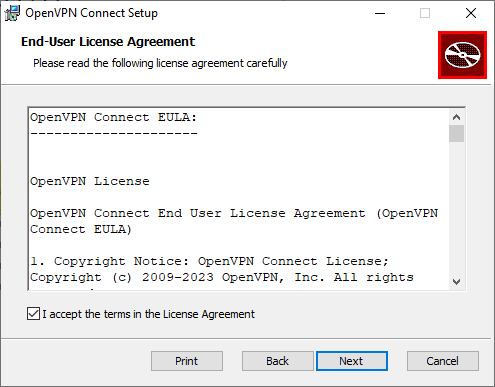

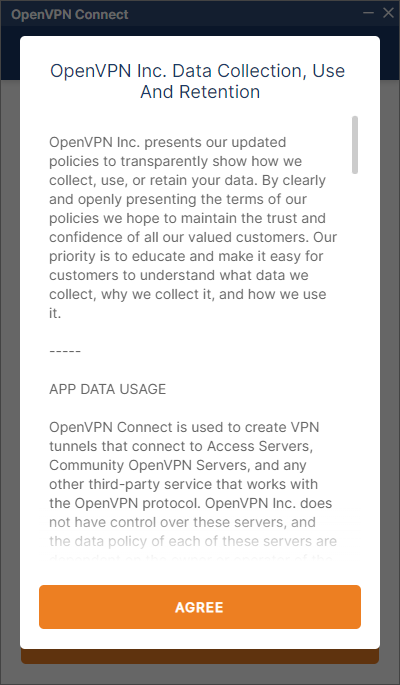

Acepte los términos de uso y siga las instrucciones de instalación:

Acepte la licencia

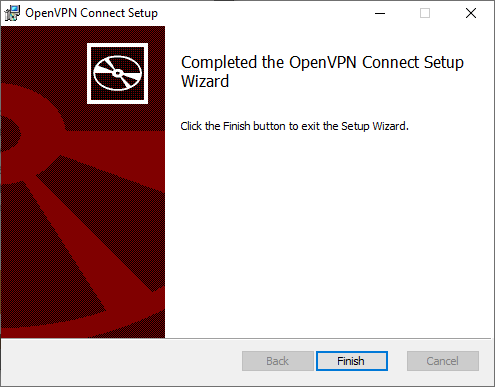

y finalice la instalación

Con esto ya tendrá instalado el cliente de OpenVPN en su ordenador personal.

Importar perfil de conexión#

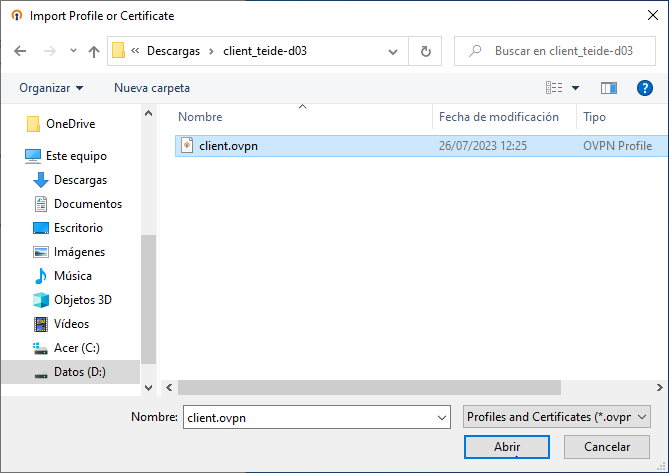

Después de recibir las credenciales cifradas con su clave pública gpg y descifrarlas deberá todos los archivos recibidos en el mismo directorio antes de importar la configuración, por ejemplo:

C:\Users\your_user\VPN\

client_teide-XYYY

├── ca.crt

├── client.ovpn

├── README.txt

├── ta.key

├── teide-XYYY.crt

└── teide-XYYY.key

Conectar a la VPN#

Busque el icono del cliente OpenVPN en el área de notificaciones de windows.

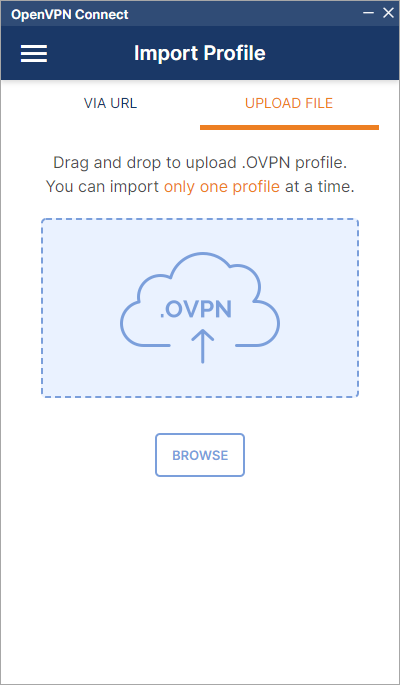

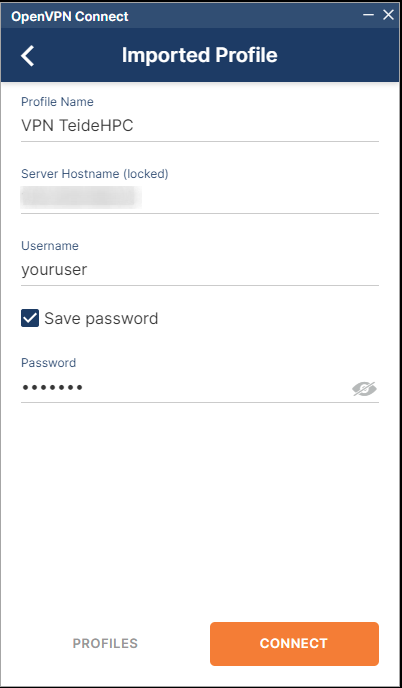

Una vez abierto podrá configurar la conexión manualmente o lo más sencillo es importar el archivo client.ovpn arrastrando, haciendo doble click sobre él o bien, pulsando el icono BROWSE

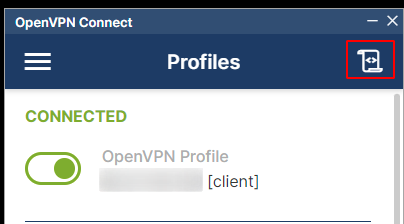

Una vez introducidas las credenciales, el su sistema operativo queda en disposición de acceder a la infraestructura de TeideHPC.

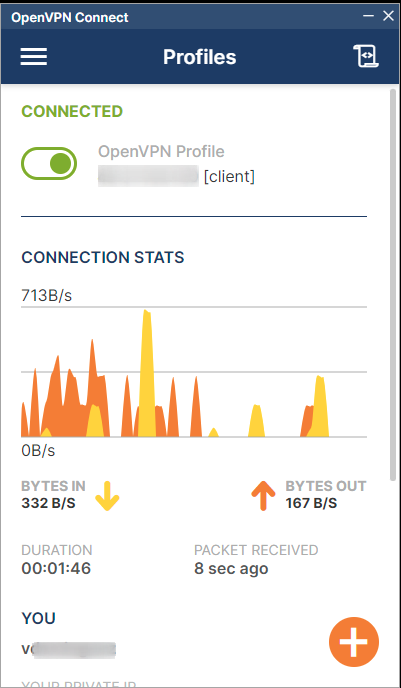

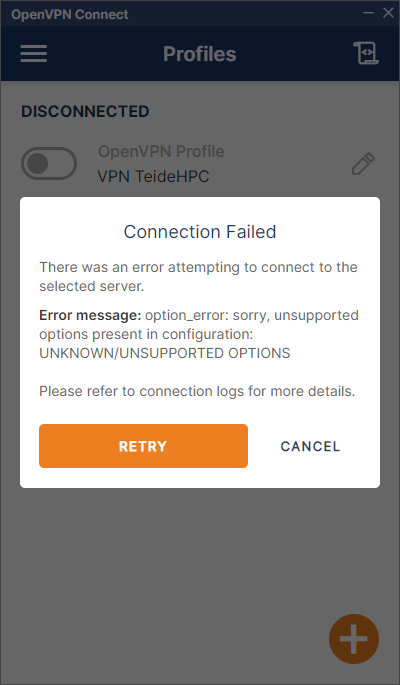

Si su conexión es satisfactoria verá el siguiente estado en la conexión creada.

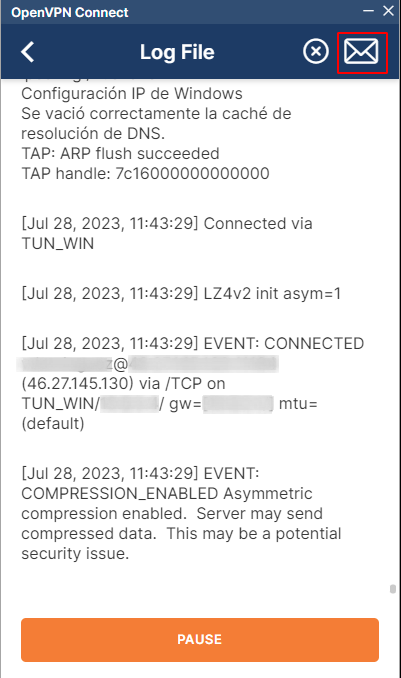

Log de OpenVPN para usuarios Windows.#

En caso de que exista algún problema con la conexión a TeideHPC es importante consultar el log de conexión.

En caso de que la conexión no sea satisfactoria, éste siempre contendrá la información del error.

En caso de que no pueda solucionar el problema por si mismo, siempre le pediremos el log completo, el cual puede exportarlo haciendo click en el sobre.

OpenVPN para macOS#

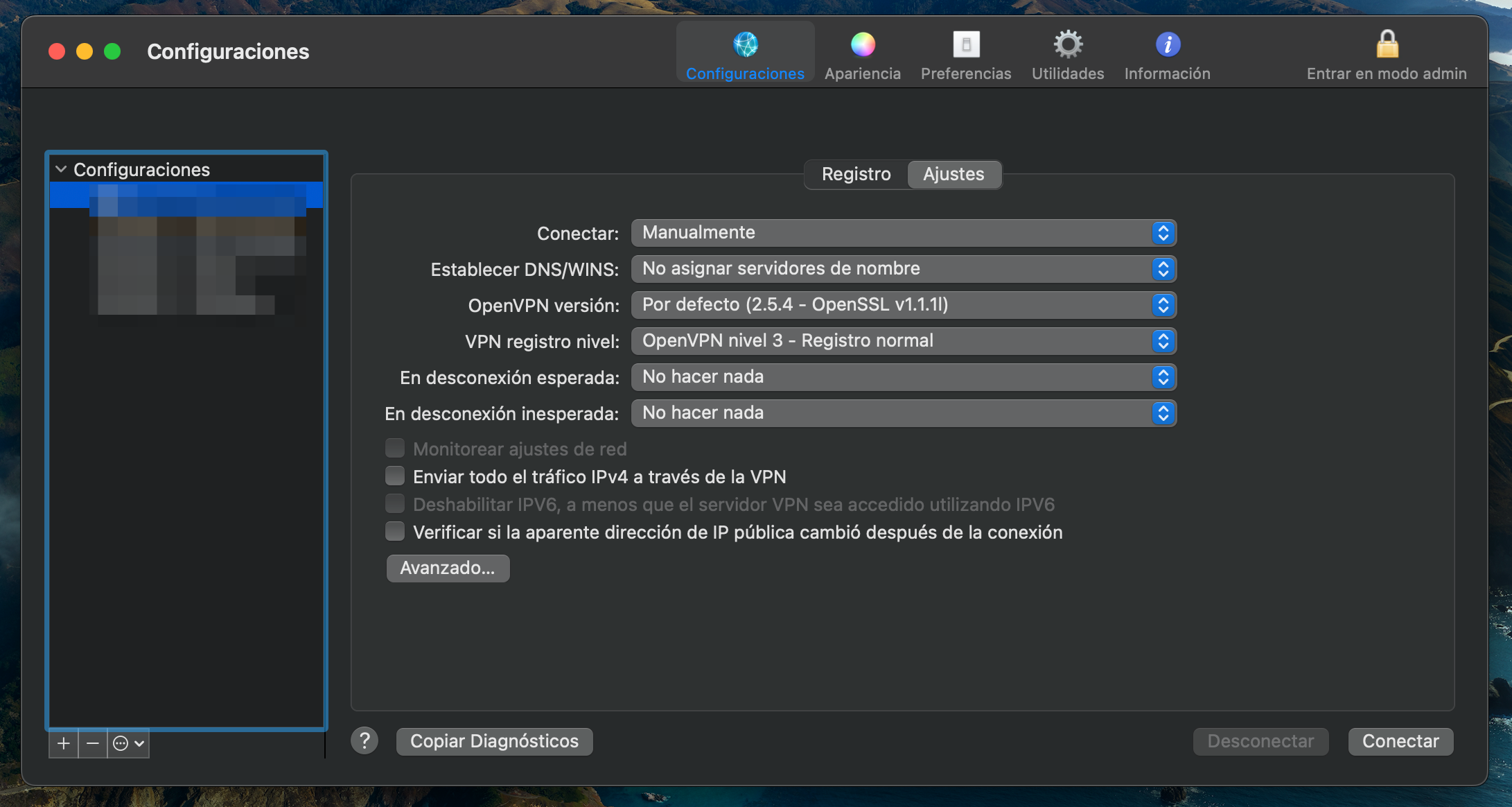

Para utilizar OpenVPN en macOS no disponemos de un cliente oficial, así que tenemos que utilizar una aplicación de terceros, Tunnelblick, que es la opción más recomendada para abrir una conexión de OpenVPN en macOS.

El presente manual se ha hecho utilizando macOS Ventura y Tunnelblick en su versión estable v3.8.7a.

En este manual no se explica su instalación.

Conectarse a la VPN utilizando Tunnelblick#

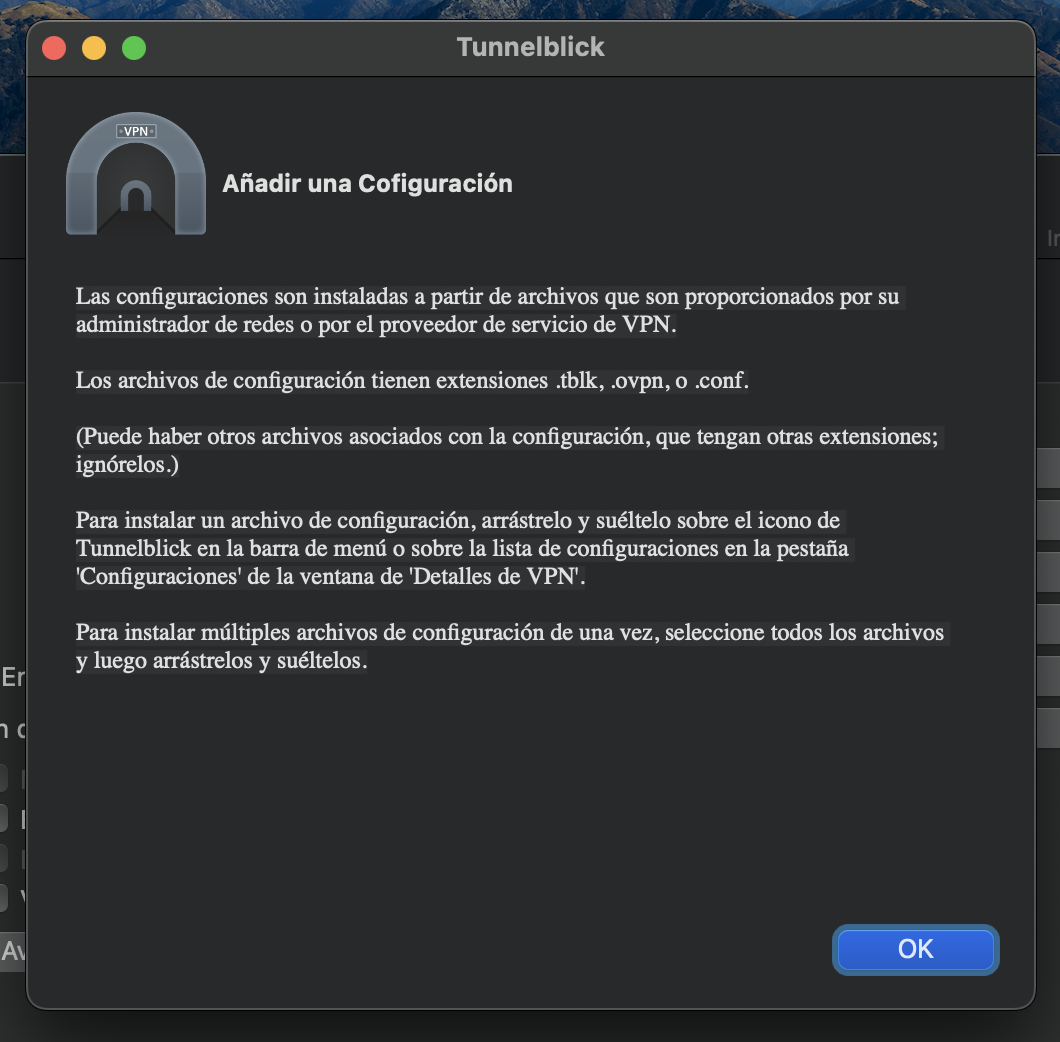

Una vez instalado el software lo abrimos para añadir una nueva conexión VPN:

Para añadir una nueva conexión, podemos darle al símbolo "+" que hay en la esquina inferior izquierda:

Tal y como vemos, para crear una nueva conexión tenemos que arrastrar el fichero de configuración al apartado de Configuraciones. En nuestro caso sería el fichero <nombre_usuario>.ovpn. Lo hacemos, arrastramos el fichero de configuración para crear una nueva configuración VPN.

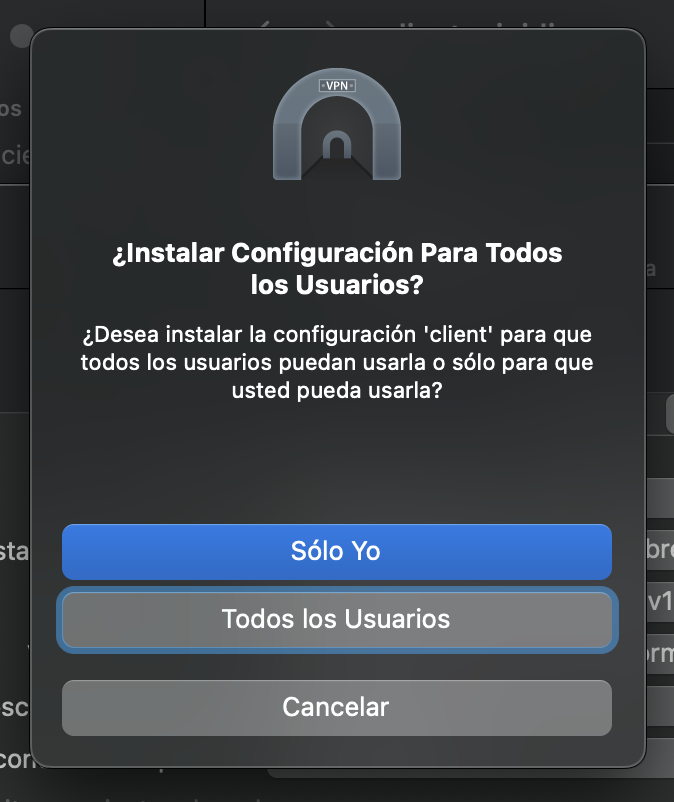

Dependiendo del ordenador en el que estemos trabajando, nos pude interesar crear la conexión únicamente para nuestro usuario o disponible para todos. En este caso, será solo para nuestro usuario, por tanto, "Solo Yo".

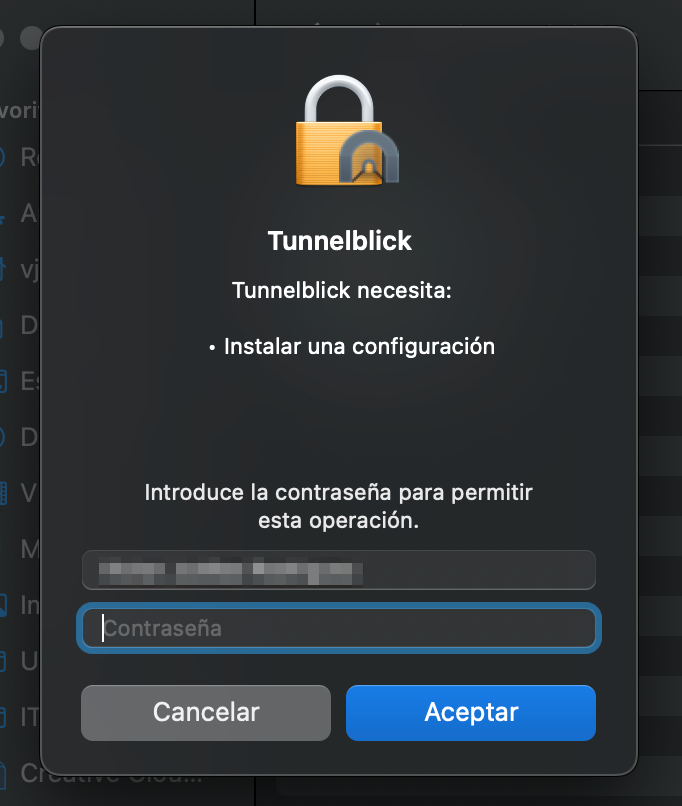

Se nos pedirá que introduzcamos la contraseña de usuario (del ordenador) para permitir que haga cambios:

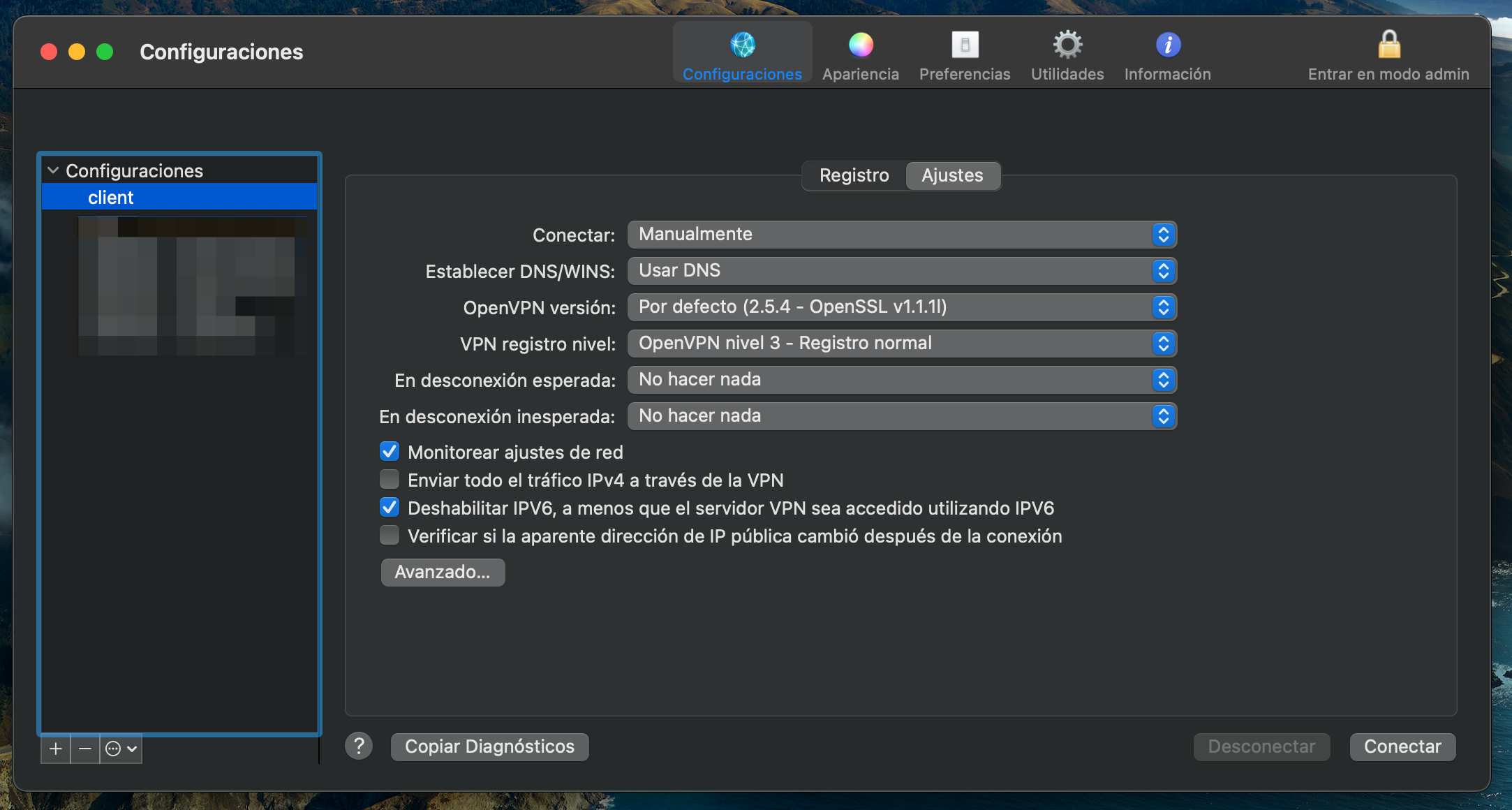

Una vez creada, aparecerá en el recuadro de la izquierda

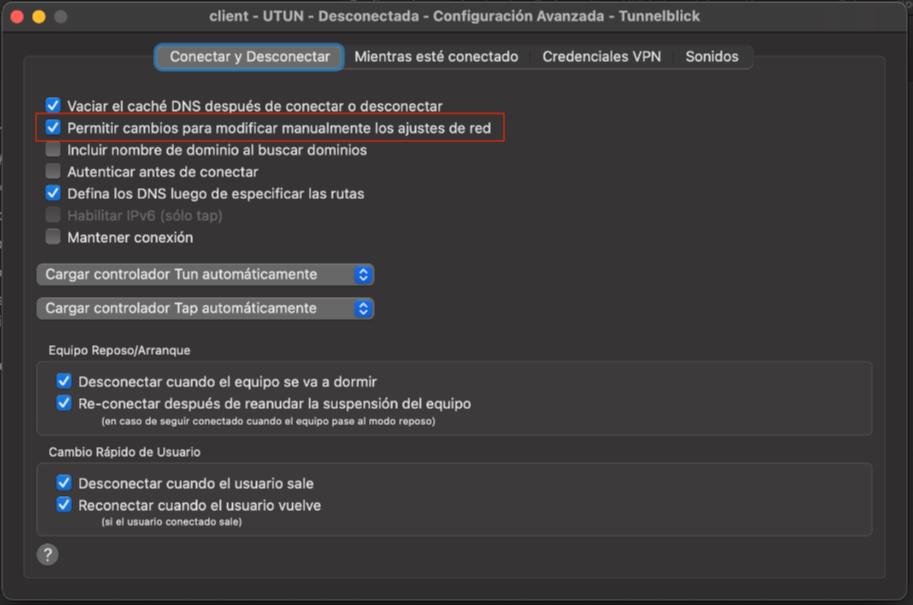

Una vez modificado la opciones avanzadas podemos "Conectar":

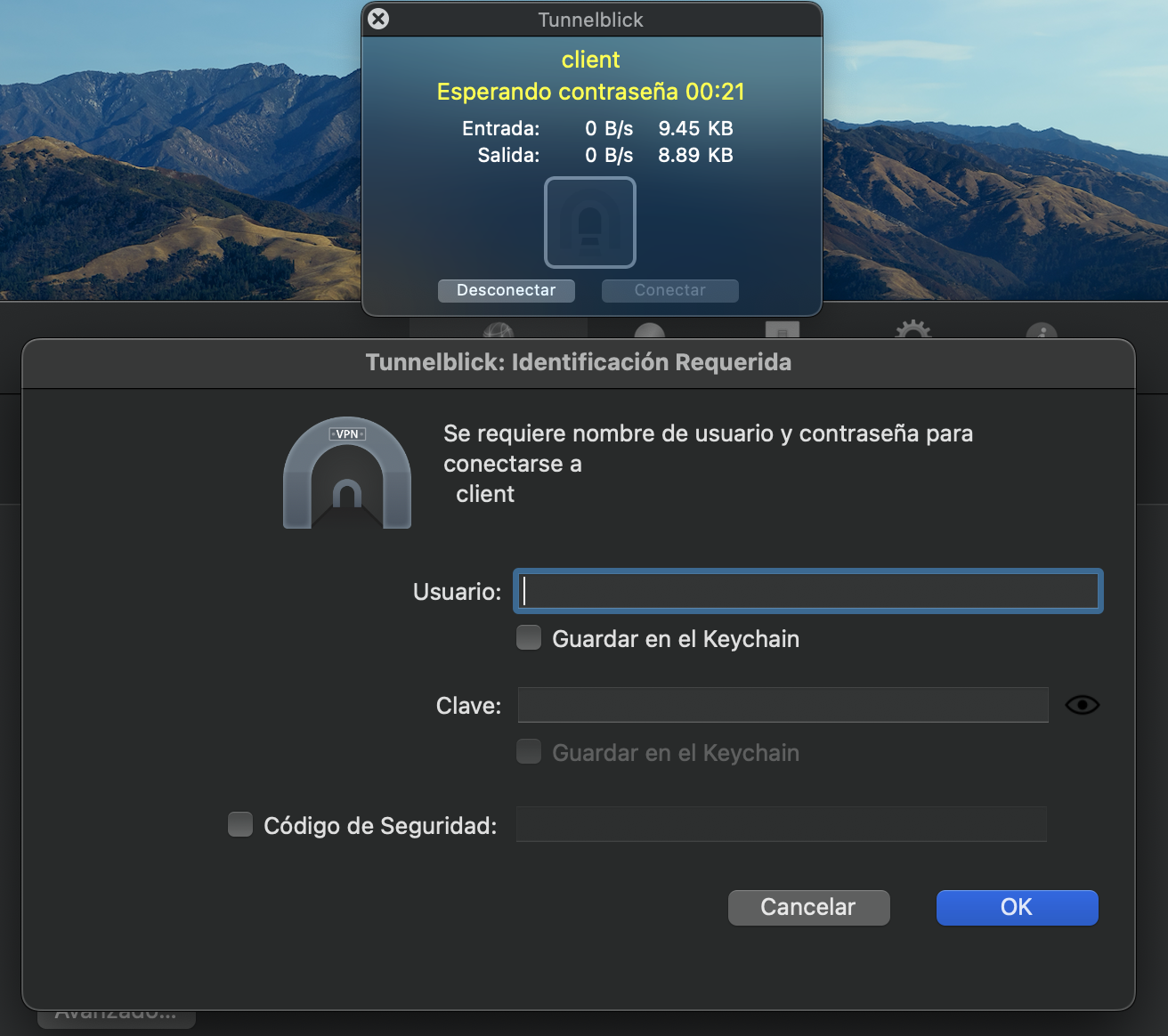

Al hacerlo, nos pedirá que introduzcamos las credenciales de la VPN, es decir, el usuario y contraseña:

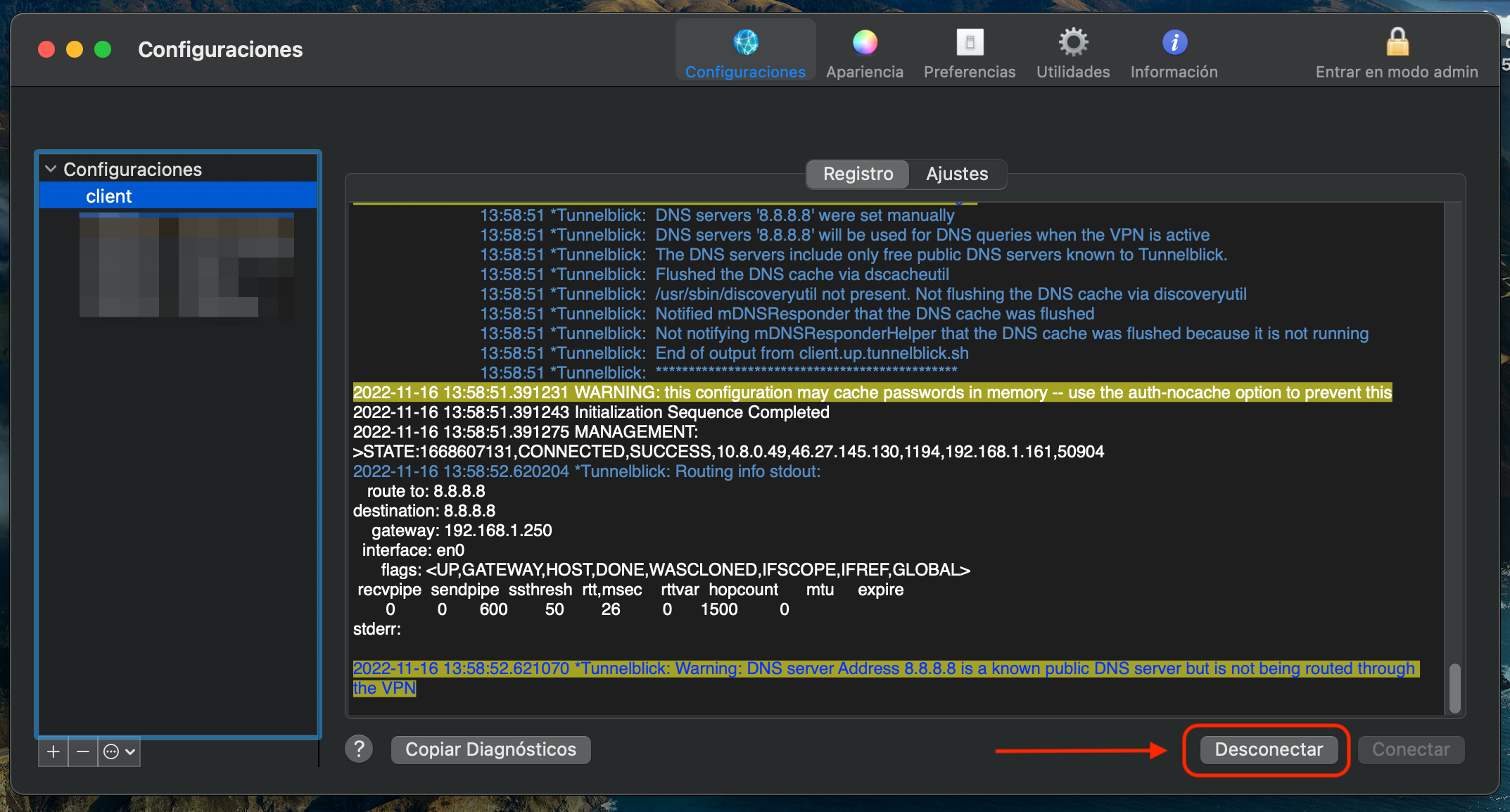

Si lo hemos introducido correctamente y todo ha ido bien, nos habremos conectado correctamente:

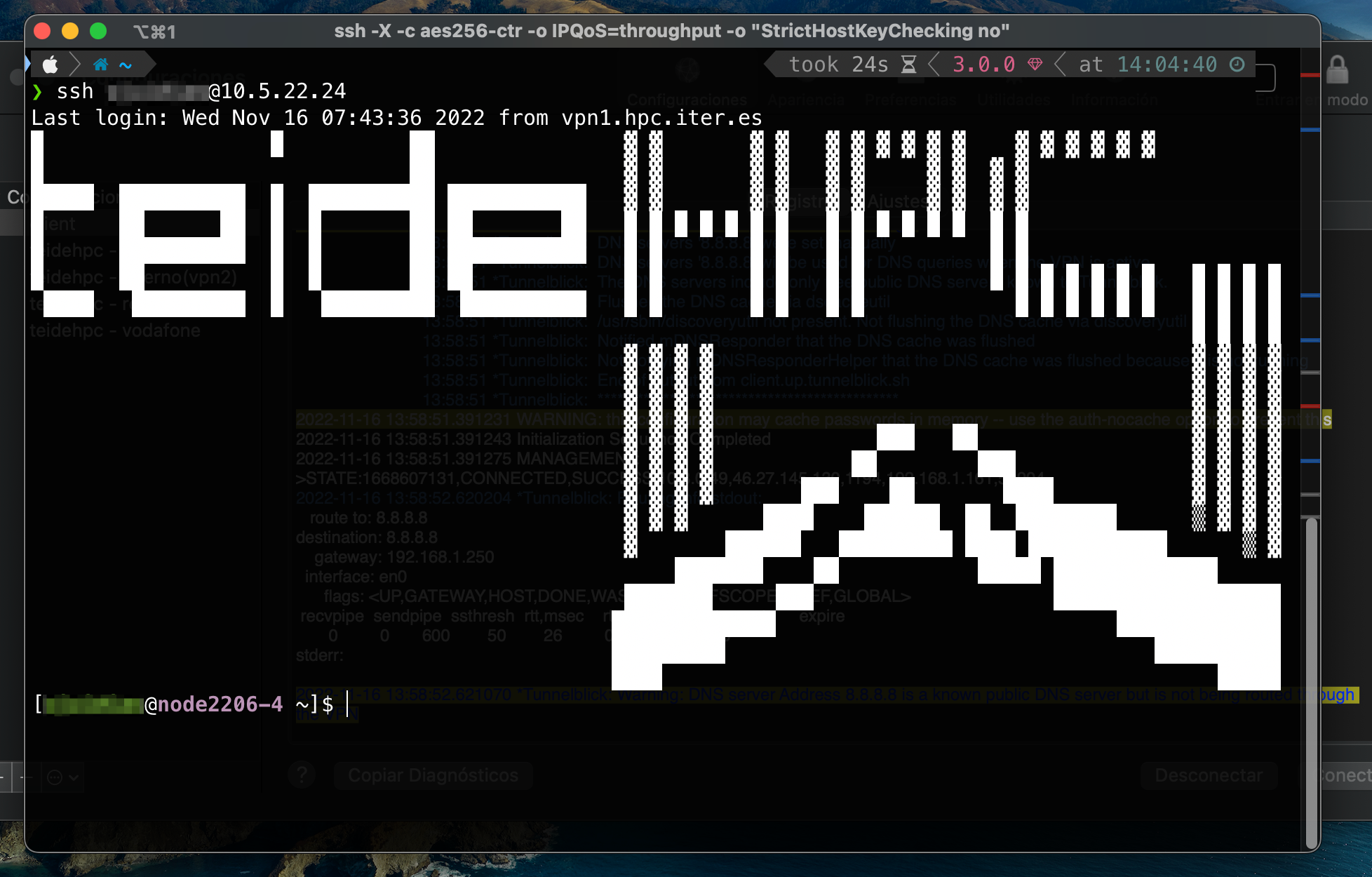

Una vez conectado a la VPN, podremos conectarnos vía SSH al nodo de login de TeideHPC utilizando la terminal:

Para desconectarnos, podemos hacerlo desde el propio programa o desde el icono del programa que encontramos en la barra superior:

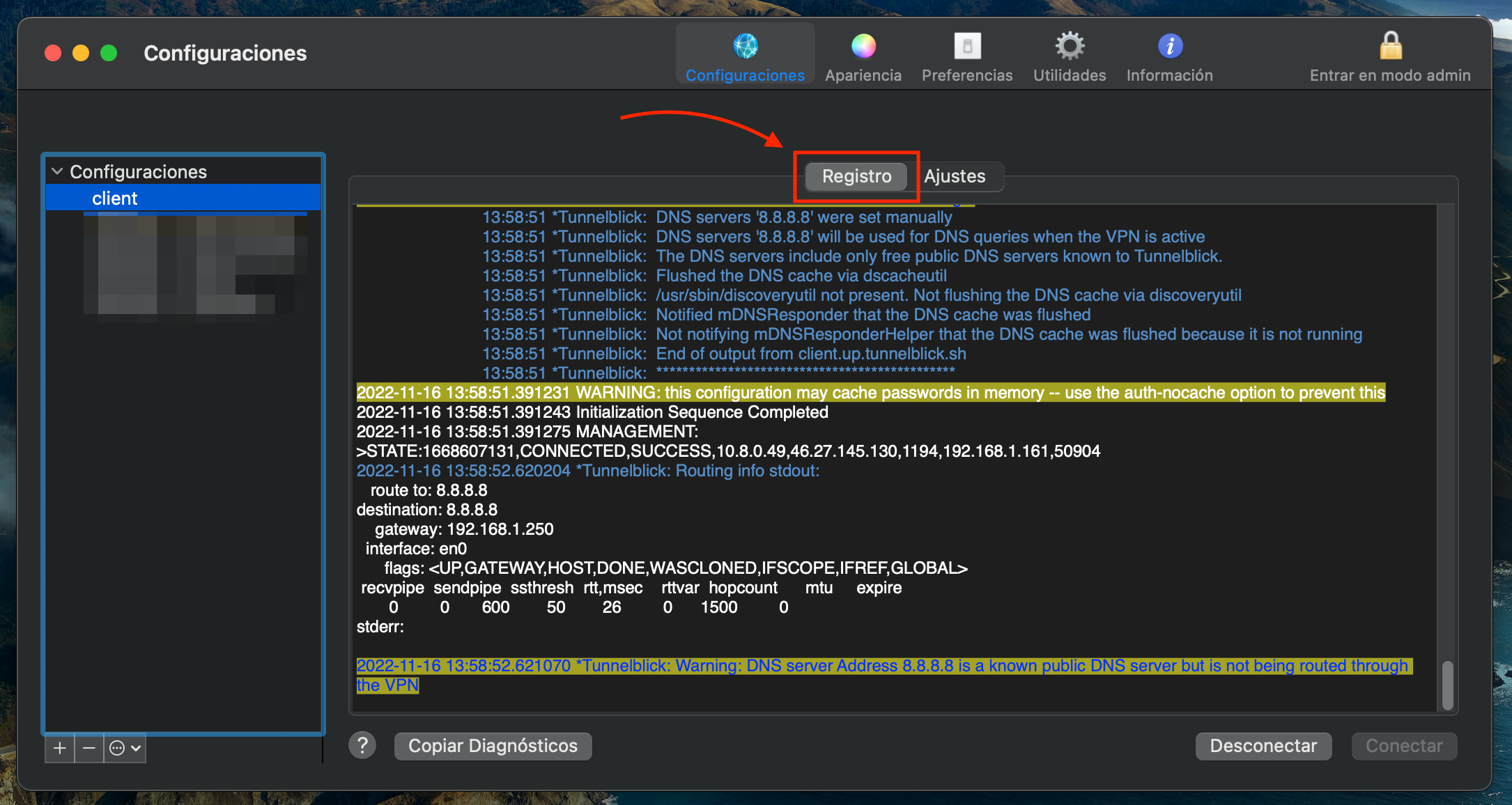

En caso de tener problemas con la conexión, tenemos disponible la pestaña "Registro" para ver los mensajes de la conexión y así poder depurar un posible problema.

Añadir los servidores DNS de TeideHPC a nuestra conexión#

Para facilitar la vida a los usuarios y no tengan que recordar todas las IPs de acceso al cluster de cómputo tenemos en funcionamiento un servidor DNS que permite resolver esas direcciones sin la necesidad de recordad la IP.

| Nombre | IP Address |

|---|---|

| dns1 | 10.5.22.37 |

| dns2 | 10.5.22.38 |

Para configurarla siga los siguientes pasos:

Añadir servidores DNS. Usuarios linux.#

Los usuarios linux pueden añadir los DNS de TeideHPC en la configuración de su conexión VPN

Mediante línea de commandos.#

Lista tus conexiones:

nmcli connection show

NAME UUID TYPE DEVICE

XXXXXXX 00000000-7777-4f70-a5ca-a5be5c9551b5 wifi --

....

teide hpc 12345678-1234-1234-1234-622e596d061e vpn --

....

Con el siguiente comando añade nuestros servidores DNS

nmcli c modify "<vpn-settings-name>" ipv4.dns '10.5.22.37 10.5.22.38'

Añade el dominio de búsqueda

nmcli c modify "<vpn-settings-name>" ipv4.dns-search 'hpc.iter.es'

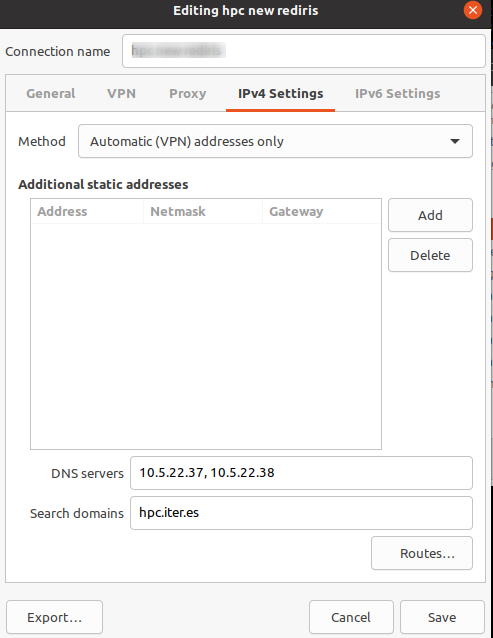

Mediante interfaz gráfica (Ubuntu y Debian)#

En una terminal escribe el siguiente comando:

nm-connection-editor

Selecciona tu conexión VPN y edítala. En la pestaña IPv4 Settings podrás añadir los DNS y el dominio de búsqueda como se muestra a continuación.

Añadir servidores DNS. Usuarios Windows#

Antes de añadir tu tu fichero de configuración client.ovpn al cliente de OpenVPN añade las siguientes líneas:

Ended: OpenVPN

Ended: Seguridad y VPN

Primeros pasos ↵

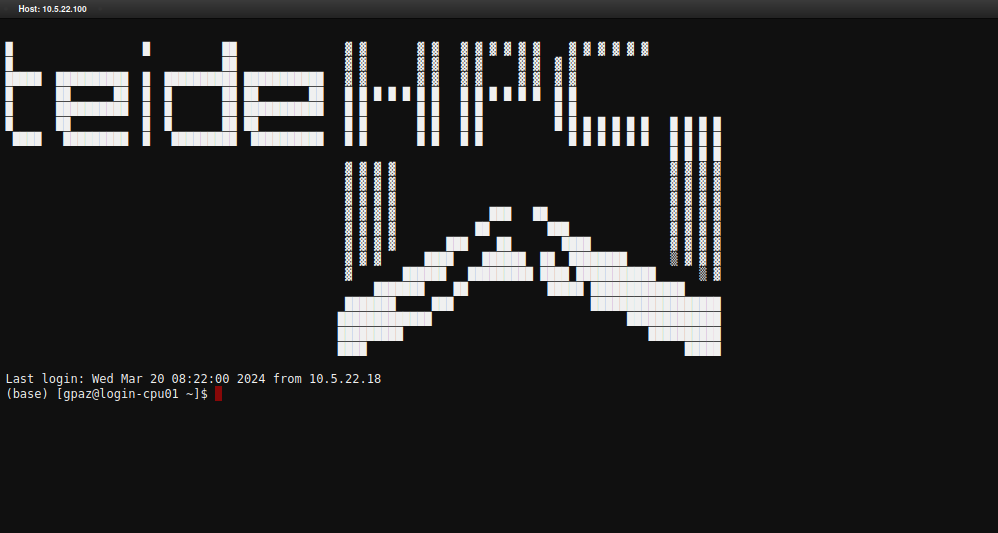

¿Cómo iniciar sesión en TeideHPC?#

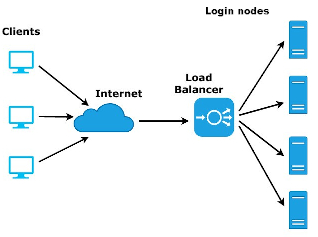

Con la llegada de la nueva infraestructura a TeideHPC, se han dispuesto varios nodos de login que permintan tener la redundancia y alta disponibilidad necesaria para mantener el cluster operativo el 100% del tiempo.

Para el acceso a la infraestructura el TeideHPC dispone de los siguientes 3 puntos de acceso, uno para cada cluster mediante consola y un acceso web.

| TeideHPC | AnagaGPU | Acceso web |

|---|---|---|

| hpclogin.hpc.iter.es | gpulogin.hpc.iter.es | https://ondemand.hpc.iter.es |

| 10.5.22.100 | 10.5.22.101 | https://myjobs.hpc.iter.es |

Recuerde que debe estar conectado a la VPN para acceder

Para asegurar que el número de usuarios no se concentre en un sólo nodo de login, el cual eventualmente acaba saturándose debido a preferencias de acceso y ejecuciones no intencionadas de los usuarios, se ha dispuesto un balanceador de carga para cada cluster el cual se encarga de distribuir a los usuarios de forma equitativa en cada uno de los 2 nodos de login que tiene cada cluster.

Todos los nodos de login comparten todo su $HOME

Es decir, independientemente a qué IP de acceso se conecten y de qué nodo le sea asignado, sus datos serán accesibles de manera indistinta.

Una vez accedes, es posible ir de un nodo a otro sin ningún tipo de restricción

El software disponible en cada cluster NO es el mismo

No todos los nodos son iguales, cada cluster tiene un tipo de nodos según la arquitectura de estos por lo que el software está compilado en su mayoría atendiendo a la arquitectura de los nodos.

En la página principal de esta documentación puede ver ver qué architecturas existen en TeideHPC.

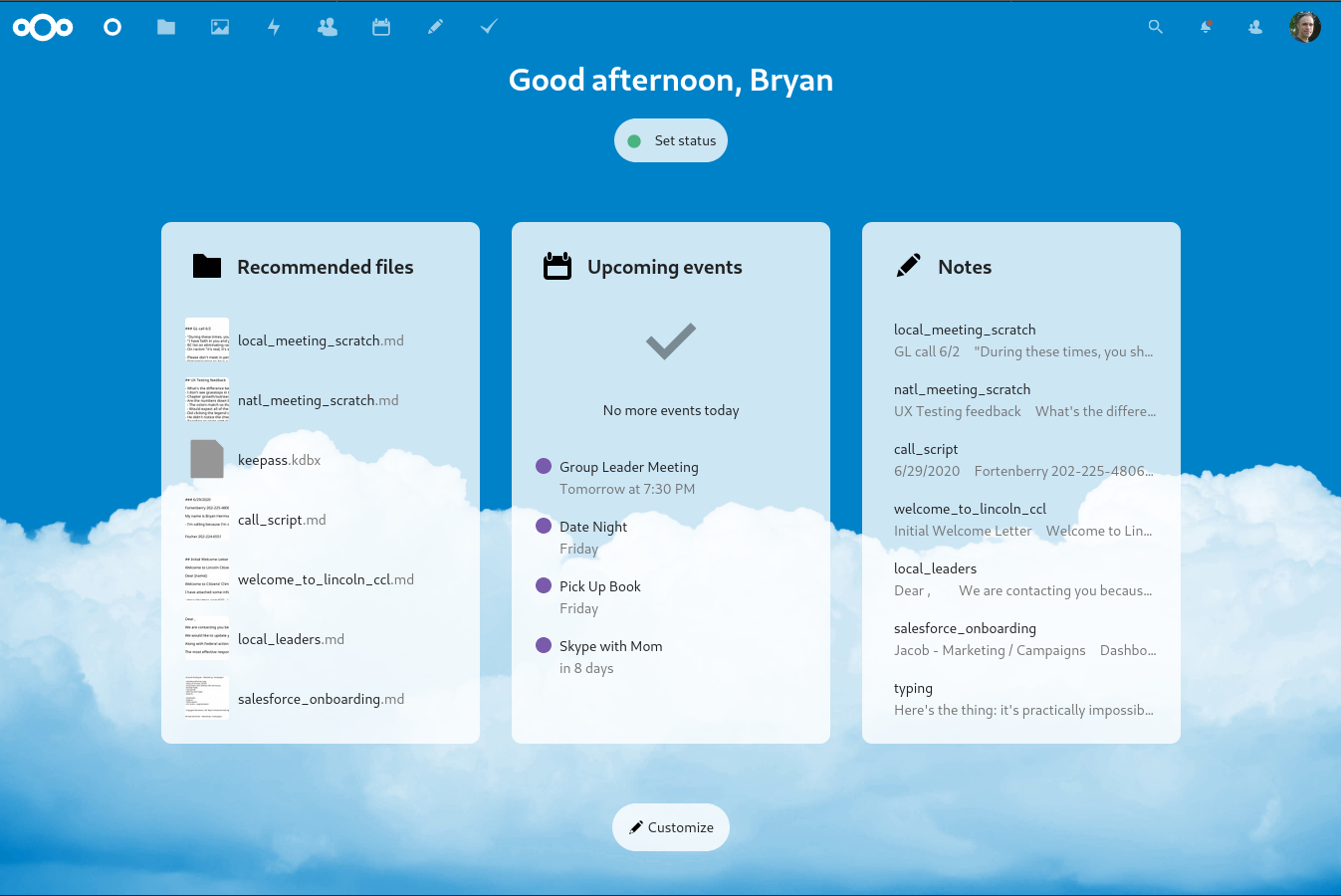

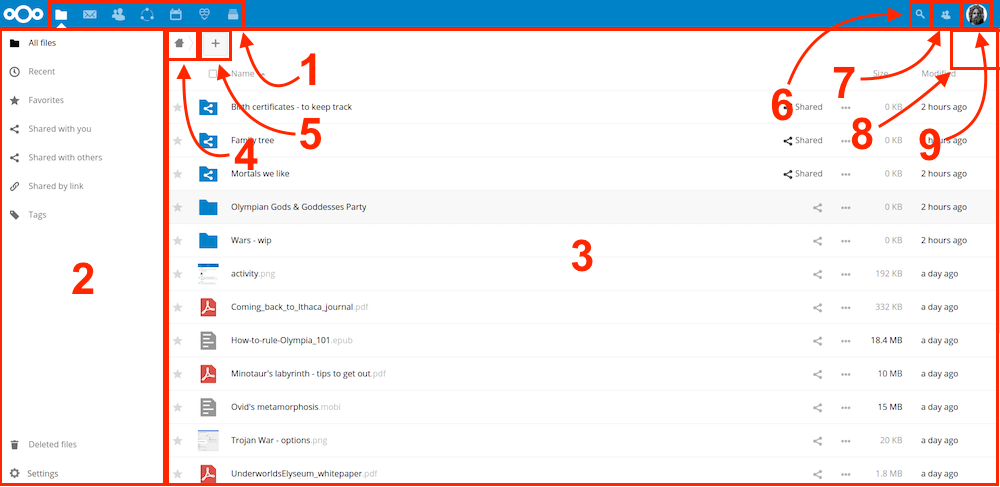

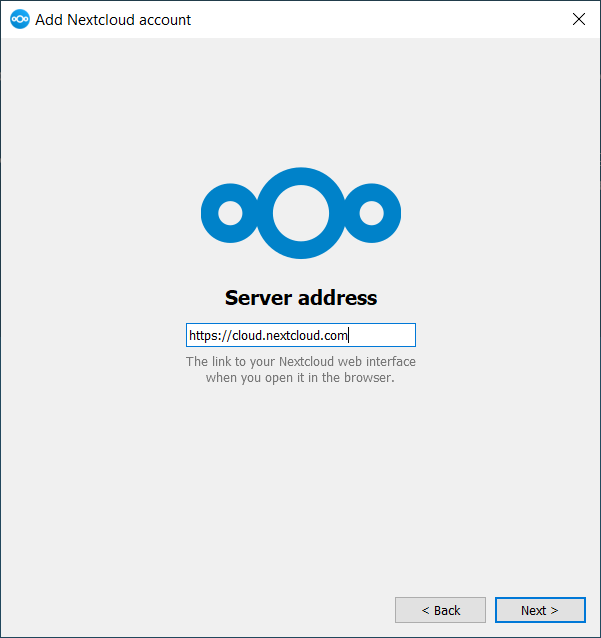

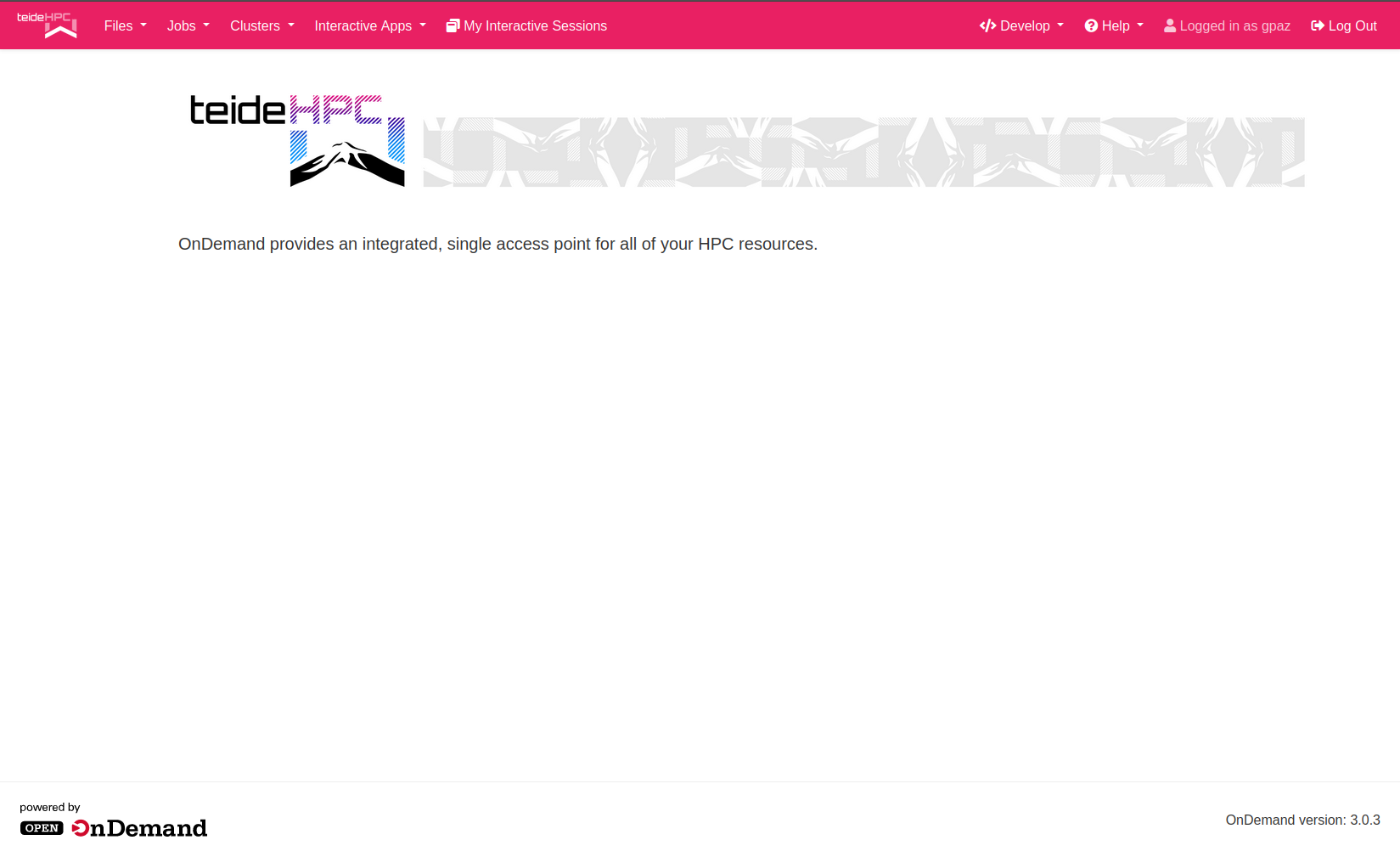

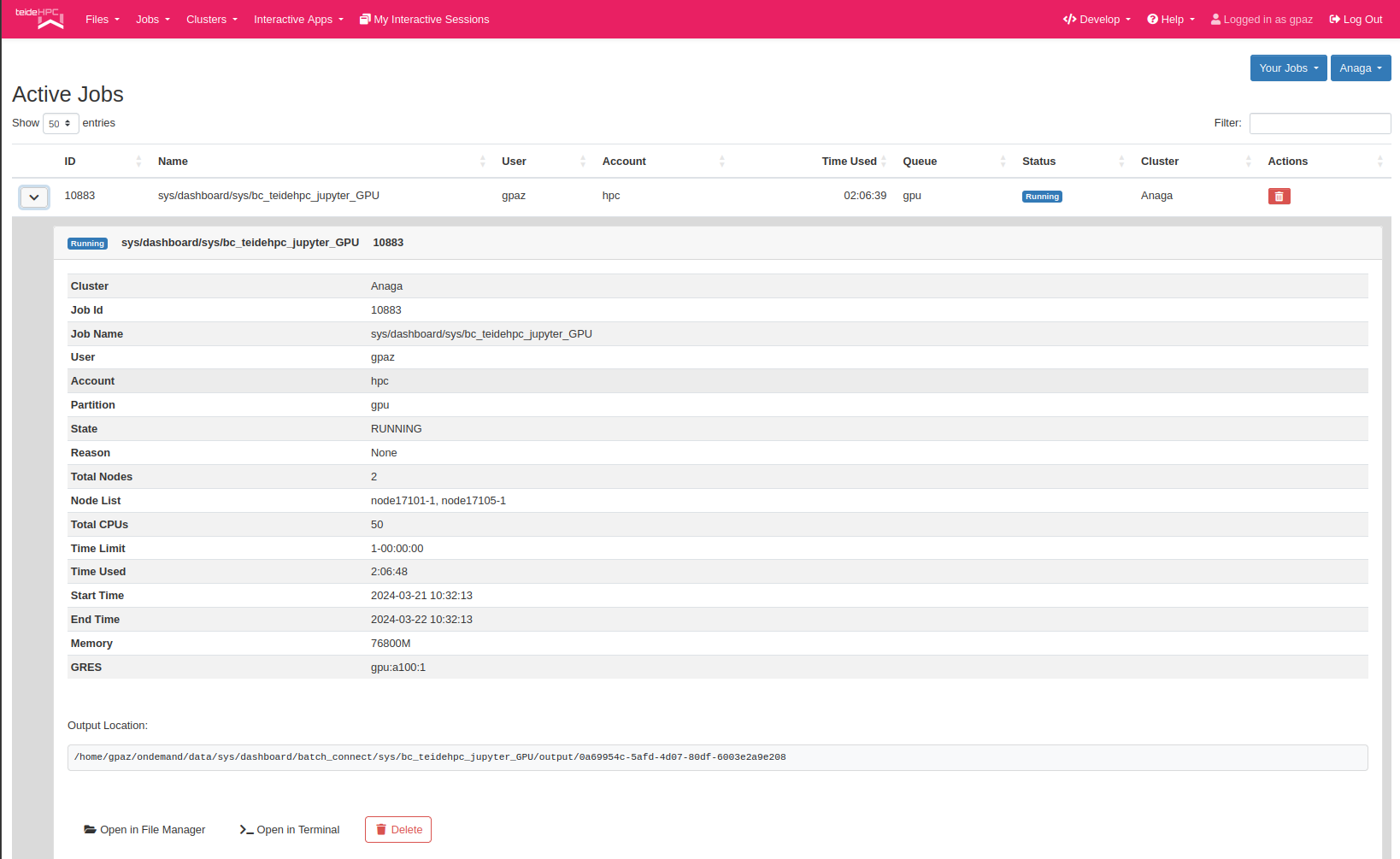

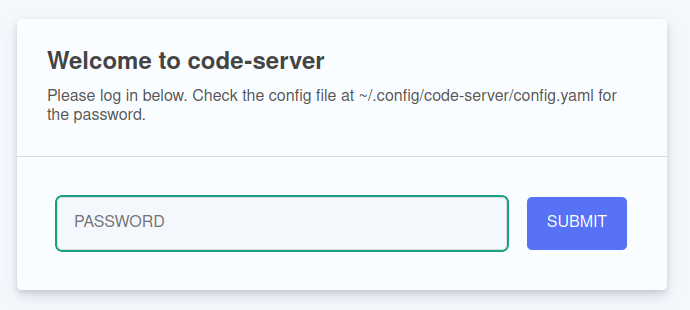

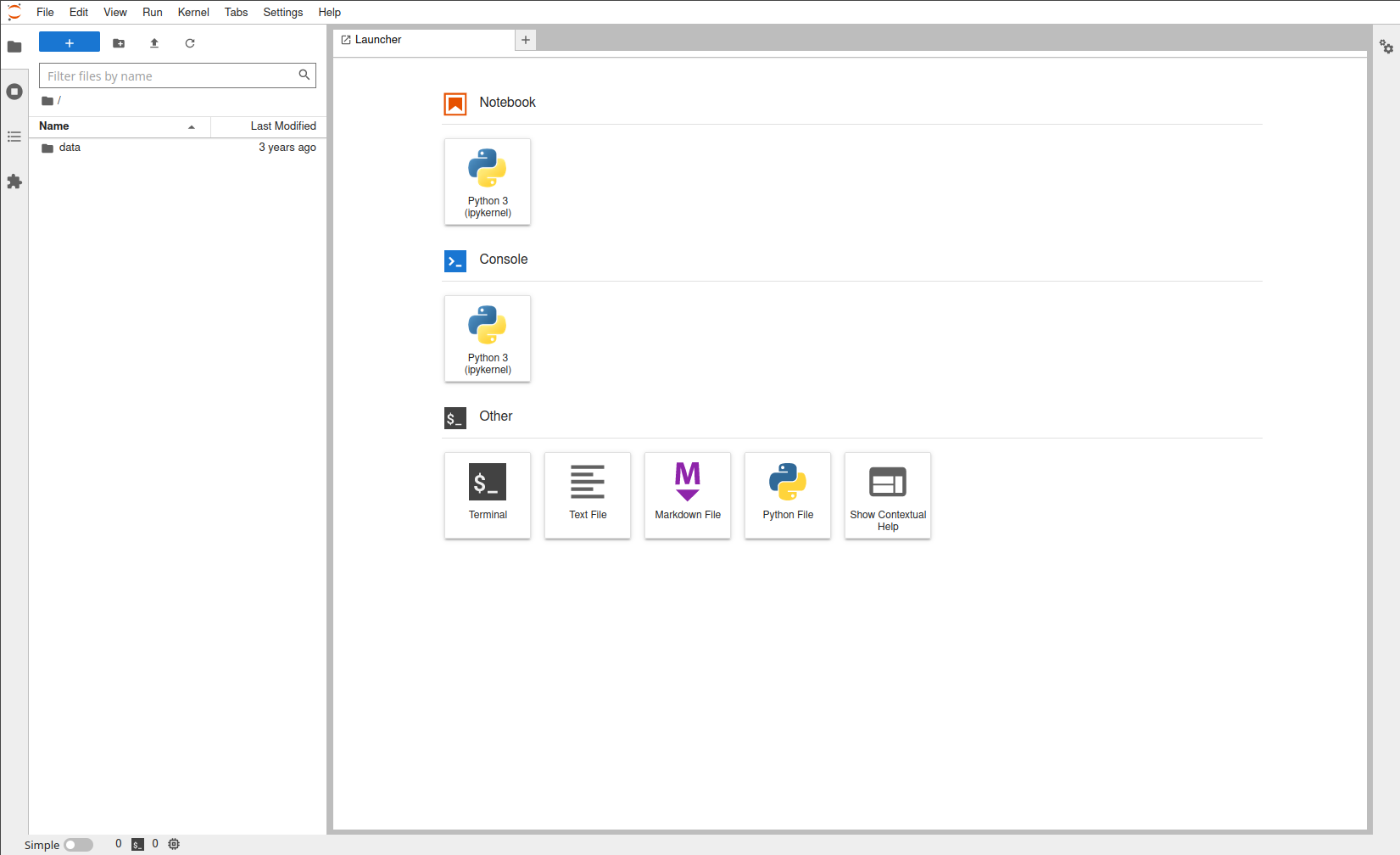

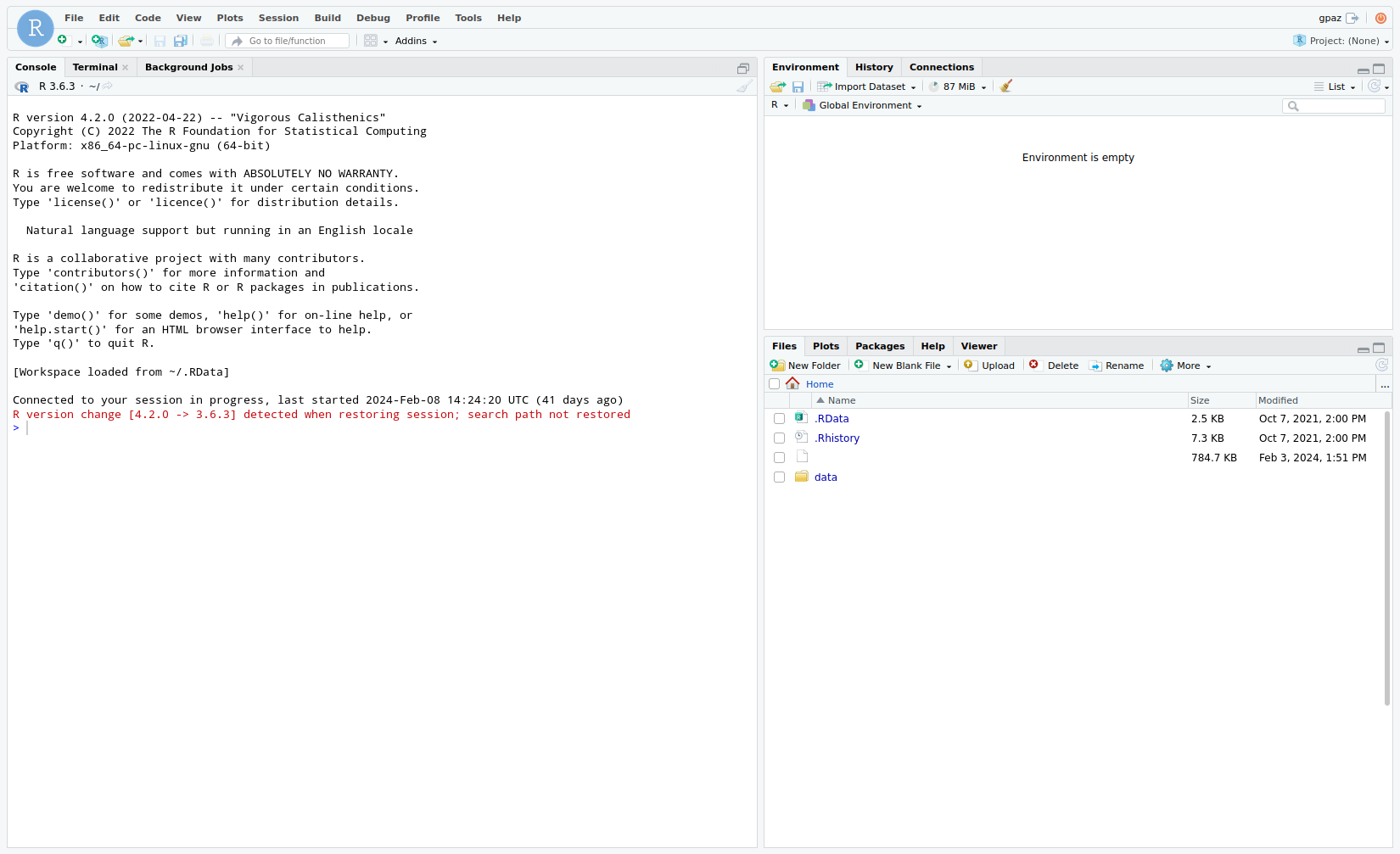

Acceso web a TeideHPC.#

Para acceder via web a TeideHPC, puedes usar el siguiente enlace: https://ondemand.hpc.iter.es

Qué es OnDemand

Básicamente es un servicio web que permite lanzar sus ejecuciones de una forma más visual, sencilla y amigable para el usuario. Para más información visite la sección en esta misma web

Recuerda que necesitarás tus credenciales de usuario para iniciar sesión.

Si tienes algún problema con el acceso, no dudes en contactarnos.

Acceso para los usuarios de Linux y macOS#

A través de una terminal:

Usar DNS en lugar de IPs

Recuerda que puedes acceder a usando nuestro DNS siempre que los hayas añadido a tu configuración.

SSH Alias#

Para que sea más sencillo trabajar y no estar recordando la IP del servidor, podemos utilizar un alias para guardar la conexión. Para ello, editamos el fichero ~/.ssh/config y añadimos lo siguiente (si no exite, lo creamos):

Host teidelogin

Hostname 10.5.22.100

User miusuario

Host anagalogin

Hostname 10.5.22.101

User miusuario

Ahora para conectarnos por ssh a los nodos de login podemos hacerlo de la siguiente manera:

Acceder con clave pública SSH#

Podemos acceder a los nodos de login sin contraseña utilizando una clave pública SSH. Si no tenemos ninguna, podemos hacerlo de la siguiente manera:

Una vez se ejecute el comando, nos pedirá dos cosas:

- Una localización donde guardar la clave y un nombre para el archivo.

- Una contraseña para encriptar la clave y que tendremos que utilizar cada vez que usemos la clave pública.

Podemos dejar vacío ambos campos. En el caso de la localización, por defecto, el par de claves se guardarán en el directorio ~/.ssh:

- Para la clave privada:

~/.ssh/id_rsa - Para la clave pública:

~/.ssh/id_rsa.pub

Warning

La clave privada la debe guardar usted y no compartirla con nadie. Es la que se usará para realizar la autenticación con el servidor. Si la pierde, no podrá conectarse utiliziando la clave pública ssh.

En cuanto a la contraseña, eso ya es desición de cada uno.

Para copiar la clave pública SSH al nodo de login, debe hacer lo siguiente:

Nos pedirá la contraseña de nuestro usuario para proceder y ya podremos conectarnos a los nodos de login sin necesidad de contraseña, simpre y cuando lo hagamos desde el ordenador donde está la clave privada.

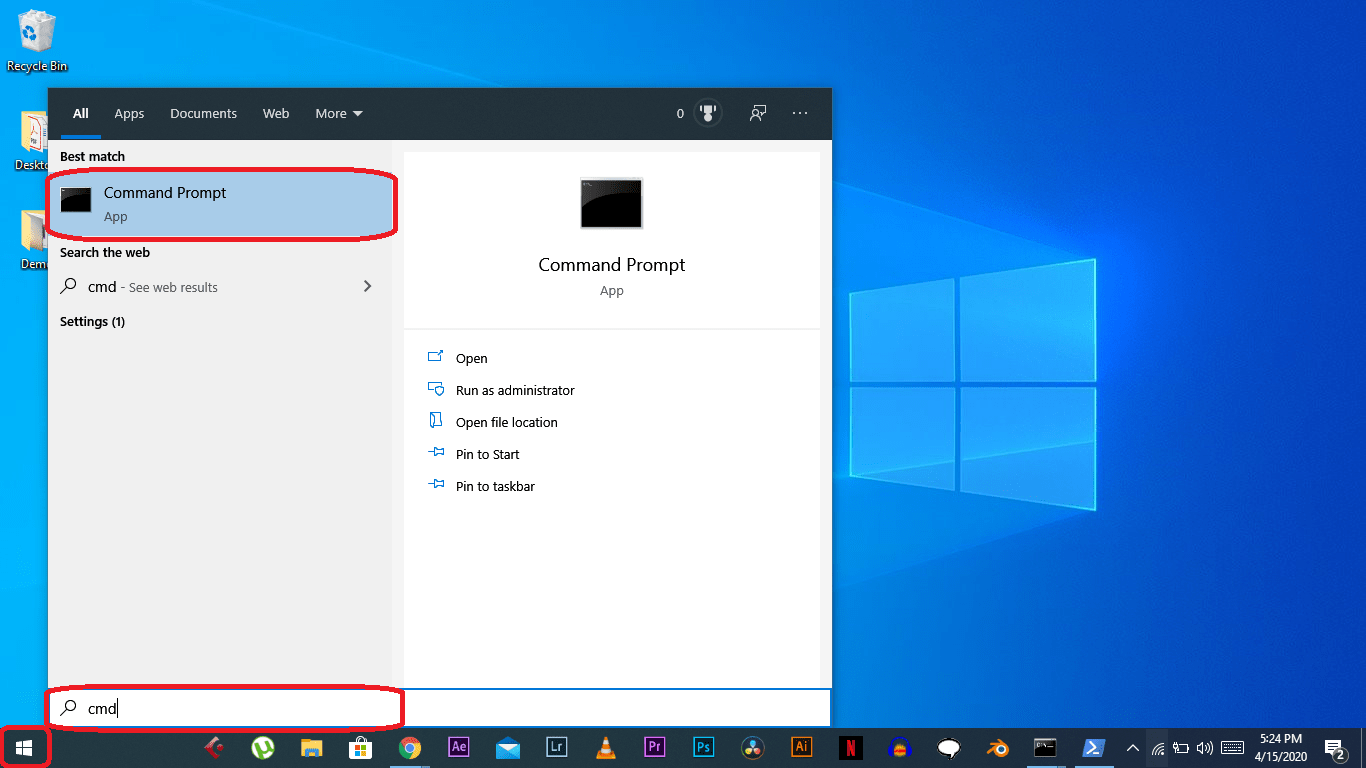

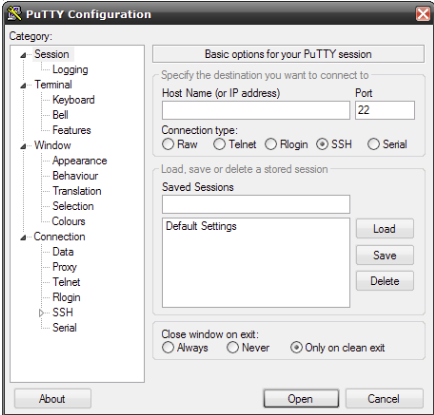

Acceso para usuarios de Windows#

Los usuarios de windows disponen de varias alternativas para conectarse vía SSH a los nodos de login. Entre ellas están PuTTY y MobaXterm:

Acceso remoto SSH con PuTTy#

PuTTy es un cliente de red que soporta los protocolos SSH, Telnet y Rlogin y sirve principalmente para iniciar una sesión remota con otra maquina o servidor. Es de licencia libre y a pesar de su sencillez es muy funcional y configurable.

Una vez descargado e instalado el software habrá que seguir los siguientes pasos para establecer la conexión con los nodos de login de TeideHPC

-

En el menú de configuración seleccione la categoría Session.

-

Introduzca el nombre de su dominio o IP en el campo Host Name y seleccione el protocolo SSH.

-

Introduzca un nombre para esta conexión en el campo Saved Sessions.

-

Vuelva al menú de configuración y seleccione la categoría SSH.

-

Asegúrese de que está marcada la opción 2 en Preferred SSH protocol version.

-

Seleccione nuevamente la categoría Session.

-

Para guardar la configuración pulse Save y Open para conectar.

Consejos:

-

For slow connections you can enable compression. You can find a checkbox in the Connection > SSH menu.

-

SSH version 2 must be set as the preferred protocol version in Connection > SSH menu.

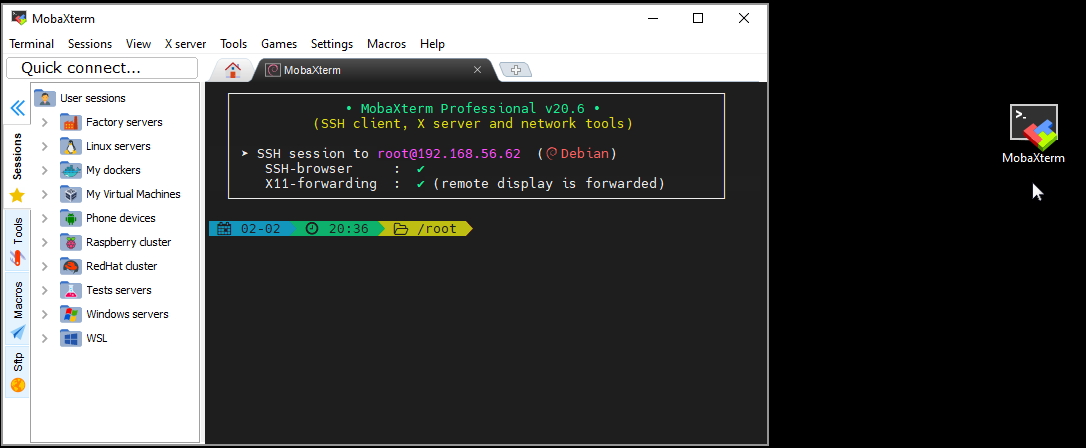

MobaXterm#

MobaXterm es un toolbox para trabajar de manera remota. En una sola aplicación proporciona un montón de funciones (SSH, X11, RDP, VNC, FTP, sFTP, MOSH, comandos unix) que están diseñadas para programadores, webmasters, administradores de TI y prácticamente todos los usuarios que necesitan manejar sus trabajos remotos de una manera más simple.

La versión gratuita tiene ciertas limitaciones como el número de sesiones simultáneas, pero puede usarse libremente sin fines comerciales.

Para configurar un cliente SSH en MobaXterm, sigue estos pasos:

-

Iniciar MobaXterm: Abre MobaXterm en tu computadora.

-

Sesión Nueva: Haz clic en el botón "Session" en la parte superior izquierda de la pantalla de inicio de MobaXterm.

-

Seleccionar SSH: En la ventana de "Session settings", selecciona la opción "SSH" en la lista de tipos de sesión.

-

Configurar Parámetros de SSH:

- Remote host: Introduce la dirección IP o el nombre de host del servidor al que deseas conectarte.

- Specify username: Puedes especificar un nombre de usuario si no quieres ingresar el nombre de usuario cada vez que te conectes al servidor.

- Port: Cambia el puerto si es necesario (el puerto por defecto para SSH es 22).

- Advanced SSH settings: Si necesitas configuraciones avanzadas como el uso de una clave SSH específica, haz clic en "Advanced SSH settings" y realiza las configuraciones necesarias.

-

Guardar la sesión (opcional): Puedes guardar la configuración de la sesión para futuras conexiones. Dale un nombre a la sesión y guarda la configuración.

-

Conectar: Haz clic en "OK" o "Open" para iniciar la conexión SSH. Si es la primera vez que te conectas a este servidor, es posible que se te pida que verifiques la clave del host y que ingreses tu contraseña.

-

Autenticación: Ingresa tu contraseña cuando se te solicite. Si configuraste una clave SSH y la contraseña de la clave, ingrésala.

-

Sesión Iniciada: Una vez que se complete la autenticación, deberías estar conectado a tu servidor a través de SSH en la terminal de MobaXterm.

En este enlace puede encontrar una gúia más detallada:

Cuentas de usuario#

Las cuentas de usuarios son proporcionados por el equipo de administración de TeideHPC previa solicitud. Las cuentas de usuario tienen carácter personal e intransferible, lo que sinigfica que está prohibido compartir las credenciales VPN, así como las contraseñas con terceras personas.

Recordamos que solo se permite una conexión VPN simultánea, es decir, no podrá estar conectado a la VPN al mismo tiempo desde dos dispositivos.

Para cualquier consulta, dificultad o necesidad de asistencia adicional, no dudes en ponerte en contacto con nosotros a través del correo electrónico support@hpc.iter.es. Estamos aquí para ayudarte.

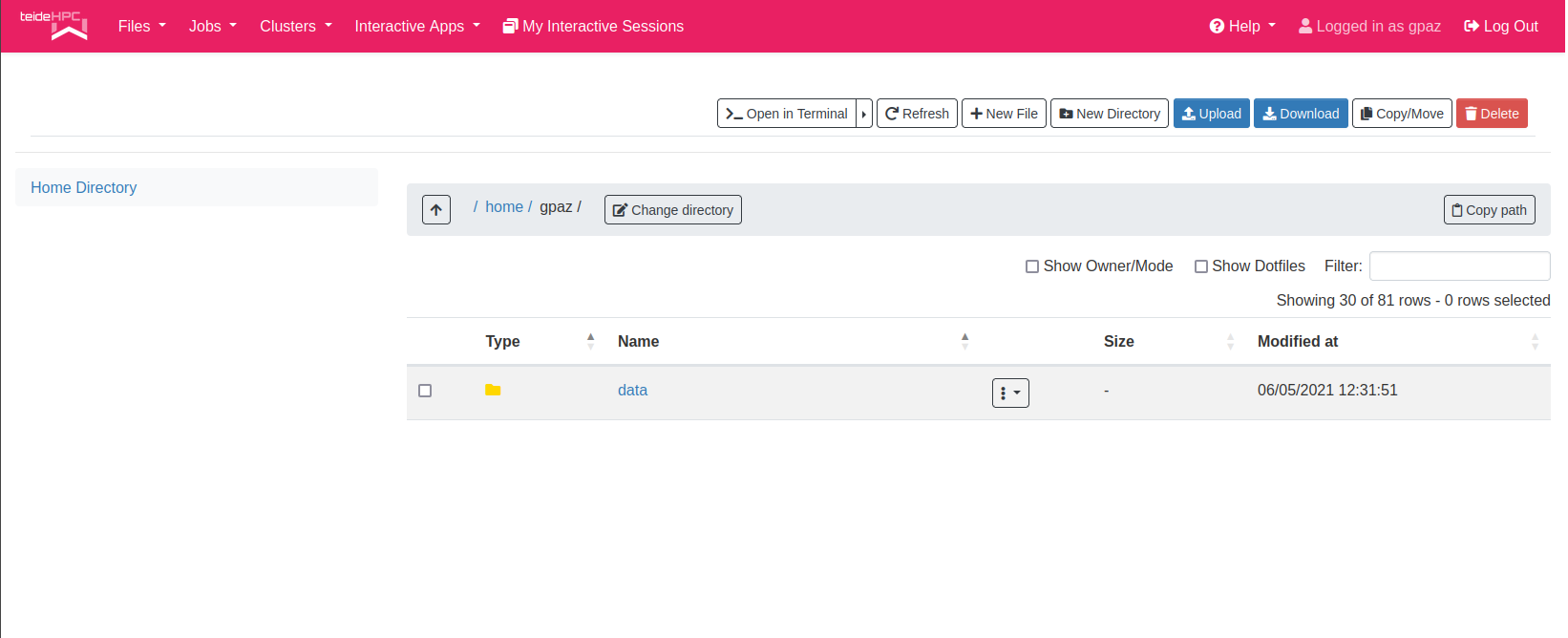

Almacenamiento#

Salvo casos particulares, las cuentas tendrán asociadas el siguiente esquema de almacenamiento:

| Almacenamiento | Capacidad | Descripción |

|---|---|---|

| /home | 5 GB | Recomendable no almacenar datos o código en esta partición. Cuando se alcance su máxima capacidad, tendrá que mover los archivos a /data |

| /data | X TB | Partición con una "cuota soft" sobre el almacenamiento contratado. Para grandes volumenes será necesario solicitarlo mediante el email de soporte (support@hpc.iter.es). Es accesible en /home/<usuario>/data |

| /scratch | -- | Almacenamiento sólo disponible bajo solicitud expresa |

| /local/<jobid> | 300GB | En el HDD local del nodo que le asigne el planificador a la ejecución. El contenido de esta partición se elimina una vez finalizada la ejecución. Al lanzar una ejecución al gestor de colas se crea la carpeta en el path indicado. El jobid es acccesible a través de la variable de entorno $SLURM_JOBID |

| /lustre | X TB | Almacenamiento de alto rendimiento basado en LUSTRE con mayores prestaciones en cuanto a ancho de banda. Debe utilizarse como almacenamiento de datos en utilización por tareas de cómputo, una vez disponibles los resultados tienen que transferirse a home o data, ya que la permanencia de datos en esta partición no está asegurada y puede someterse a operaciones de limpieza periódicamente. Es accesible /home/<usuario>/lustre |

Cualquier cambio en este esquema de almacenamiento será notificado.

Tu directorio home tiene un límite soft de 5GB.

¡¡¡Recomendamos guardar tus entornos virtuales, datos de aplicación y resultados en el directorio data or lustre (si necesitas almacenamiento de alto rendimiento!!!

Copias de seguridad#

Los datos de los usuarios están respaldados por el sistema de copias de seguridad del sistema de almacenamiento. El esquema de las copias de seguridad es el siguiente:

- Para /home, 6 copias horarias, 2 copias diarias y 2 semanales.

- Para /data, 6 copias horarias, 2 copias diarias y 2 semanales.

Para /local no hay copias de seguridad, porque es un almacenamiento situado en los discos duros de los nodos de cómputo, enfocado a mejorar el rendimiento de los trabajos. Una vez éstos terminen, el contenido de esta partición se borra por completo. La idea es que, una vez se inicie la ejecución del trabajo, el usuario copiar los datos con los que va a trabajar a esta partición del nodo y, antes de que finalize por completo el trabajo, es decir, en el mismo script de ejecución, mueva los resultados obtenidos a su espacio en data.

Para /lustre tampoco hay ningún sistema de copias de seguridad por la misma razón. Es un almacenamiento dedicado a optimizar las ejecuciones de los usuarios, pero esta vez, utilizando la red infiniband que interconecta todos los nodos y que cuenta con velocidades muy superiores al resto de redes. La idea es que el usuario copie los datos de las ejecucuciones aquí, y cuando estas terminen, mueva los resultados de vuelta a su espacio en data. En este caso, nosotros no borramos nada, pero si por algún motivo ocurre algún problema y los datos se ven afectados o el usuario borra datos por equivocación, no hay copias de seguridad para recuperar dichos datos.

Repositorio con ejemplos#

El conocimiento no tiene ningún poder si no puede ser compartido. (José A. Pallavicini)

Según las solicitudes de nuestros usuarios experimentamos con diferentes aplicaciones y librerías e intentamos documentar ejemplos simples para ellos.

Visita nuestro repositorio en github https://github.com/hpciter/user_codes

Ended: Primeros pasos

Ended: Guías de usuario

Conceptos HPC ↵

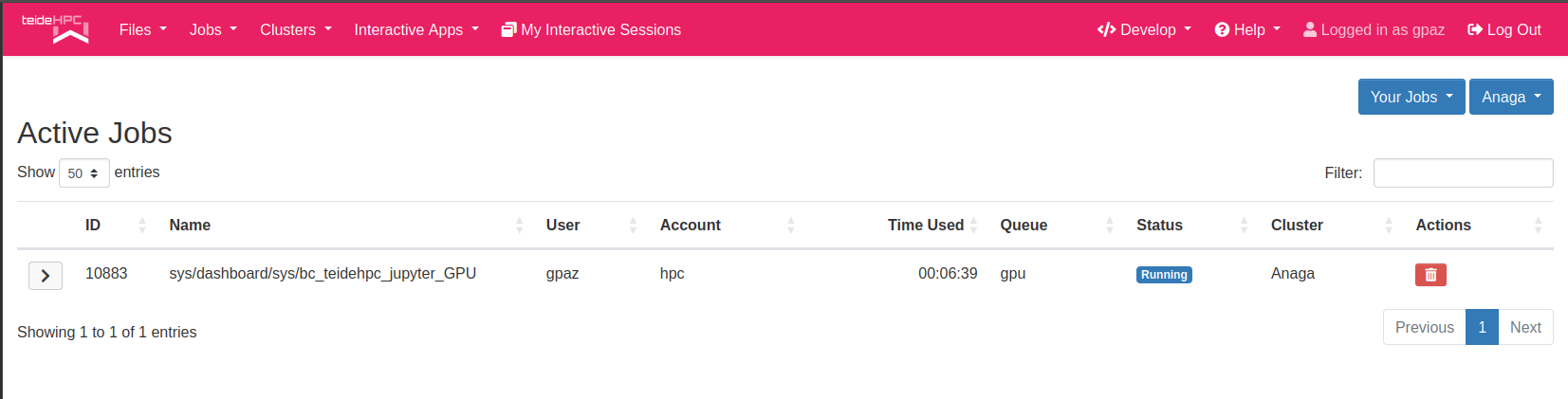

Slurm ↵

Qué es SLURM#

SLURM es un sistema de planificador de trabajos y administración de clústeres de código abierto y altamente escalable para clústeres grandes como es el TeideHPC.

Este planificador tiene tres funciones clave.

-

Asigna acceso exclusivo y/o no exclusivo a los recursos (nodos de cómputo) a los usuarios durante un período de tiempo para que puedan realizar el trabajo.

-

Proporciona un marco de trabajo para iniciar, ejecutar y monitorear los trabajos (normalmente un trabajos paralelos) en el conjunto de nodos asignados.

-

Arbitra la disputa por recursos administrando una cola de trabajo pendiente.

Actualmente en el cluster se dispone de la versión 19 de SLURM.

Los conceptos más importantes dentro de slurm son:

- Nodos de cómputo.

- Particiones.

- Trabajos.

- Tareas que representan un proceso dentro de un trabajo.

Nodos de login#

Desde los nodos de login es desde donde el usuario interactúa con Slurm y desde donde lanza y monitoriza sus trabajos. Desde aquí, el usuario accede a sus datos y a los resultados de las ejecuciones.

Info

Hay que recordar que los nodos de login son de uso compartido por todos los usuarios, por lo que está prohibida la ejecución de software en dichos nodos. Para ello se debe usar el planificador Slurm.

Particiones#

Las particiones se pueden considerar colas de trabajos, cada una de las cuales pueden tenier una variedad de restricciones como límite de tamaño del trabajo, límite de tiempo del trabajo, usuarios autorizados a usarlo, etc. Al lanzarse los trabajos en una partición concreta, éstos son ordenados por prioridad dentro de una partición hasta que los recursos (nodos, procesadores, memoria, etc.) dentro de esa partición están agotados pudiendo quedar a la espera.

Las particiones definidas en nuestro cluster son las siguientes y sus únicas rectricciones son el tiempo y los usuarios que puede usarla:

| Partición | Tiempo máximo | |

|---|---|---|

| express | 3 horas | todos los usuarios |

| batch | 24 horas | todos los usuarios |

| long | 72 horas | todos los usuarios |

| fatnodes | -- | previa solicitud a los administradores |

| gpu | -- | previa solicitud a los administradores |

Si no se especifica ninguna, la partición por defecto es las batch.

Si su trabajo va a durar más del tiempo máximo que establecido por la partición donde lo ha lanzado contacte con support@hpc.iter.es para pedir una ampliación de tiempo límite.

Comandos más comunes en SLURM#

Para familariazarse con el planificador a continuación se detallan los comandos más comunes de slurm. Para obtener mas información acerca del comando como opciones siempre puede ejecutar

sbatch <script file>: lanzar un script al gestor de colassqueue: verificar el estado de los trabajos en las colasscancel <job_id list>: cancelar un trabajoscontrol show job <job_id>: obtener información del estado de un trabajosinfo: ver estado de las colas del sistemasalloc <opciones>: iniciar sesión interactiva (obtener un nodo para ejecutar)srun <aplicacion>: enviar un trabajo a ejecutar o inicia los pasos del trabajo en tiempo realsacct: consultar el accounting de la propia cuentasstat: obtener información sobre los recursos utilizados por un trabajo en ejecución

Puede ver una guía resumen más detallada en nuestra seccion Comandos útiles en slurm o en la página oficial de slurm.

Gestión de trabajos ↵

Cómo Ejecutar Trabajos en Slurm#

Lanzar una Ejecución#

Existen tres métodos principales para lanzar trabajos en Slurm: sesiones interactivas, ejecución de trabajos en tiempo real, y envío de trabajos mediante scripts. Cada método requiere especificar los recursos necesarios.

Ejecución de Sesión Interactiva#

Usando el comando salloc, Slurm proporcionará al usuario un nodo de cálculo donde, de manera interactiva, el usuario puede trabajar y ejecutar cualquier software necesario. Esta es una opción muy útil para probar nuevo software o nuevos datos para trabajar, sin la necesidad de lanzar trabajos a la cola, con el riesgo de que fallen tan pronto como comiencen.

Solicitar un único núcleo:

Aviso

Los parámetros predeterminados asignados por slurm son:

Solicitar múltiples núcleos:

En este comando, estamos solicitando acceso exclusivo a un nodo entero, asumiendo que el nodo dispone de 16 núcleos. Este tipo de solicitud es particularmente útil para tareas que requieren una gran cantidad de memoria y recursos de CPU, permitiendo que la aplicación aproveche completamente los núcleos del nodo sin compartirlos con otros trabajos. Esta configuración maximiza el rendimiento para cargas de trabajo intensivas en cálculo o memoria.

Solicitar un nodo de una partición particular, con un nombre de trabajo y una duración determinada:

Información

Después de asegurar los recursos, podrías ver un mensaje como:

Y cuando el trabajo comienza:

Toma nota!

Una vez que tenemos un nodo vía `salloc`, podemos, desde otro terminal, acceder a ese nodo vía **SSH** para tener varias sesiones abiertas en el mismo nodo y trabajar en múltiples cosas al mismo tiempo.

Saliendo de la sesión:

Una vez que salimos del nodo desde el terminal donde hicimos salloc, Slurm liberará el nodo y el trabajo se marcará como completado. Obviamente, una vez que salimos, todas las sesiones adicionales que hayamos abierto vía SSH se cerrarán automáticamente.

Ejecutando un Trabajo en Tiempo Real#

Usa el comando srun para lanzar un trabajo directamente en la cola:

Este comando envía directamente un trabajo solicitando 16 núcleos, lo cual es útil para aplicaciones que necesitan procesamiento paralelo.

Más opciones disponibles:

| Nombre | Dirección IP |

|---|---|

| -p <partition> | partición en la que se ejecutarán los trabajos |

| -N <nodes> | número de nodos |

| -n=<num_tasks> | número de tarea |

| --tasks-per-node=<number> | tarea por nodo (considerar -N) |

| -J <job_name> | nombre del trabajo |

| -t <days-HH:MM:SS> | tiempo esperado |

| -d=<type:job_id[:job_id]> | tipo de dependencia del trabajo y id de dependencia (opcional) |

| -o </path/to/file.out> | archivo para stdout (flujo de salida estándar) |

| -e </path/to/file.out> | archivo para sterr (flujo de error estándar) |

| -D <directory> | directorio predeterminado para ejecución |

| --mail-user=<email> | email para notificaciones de slurm |

| --mail-type=<eventos> | lista de eventos para notificaciones |

Ejecutar en SLURM vía un script#

El comando sbatch envía un trabajo a la cola para ser ejecutado por uno o más nodos, dependiendo de los recursos que se hayan especificado.

La estructura más básica para un script es la siguiente:

#!/bin/bash

#SBATCH -J <job_name>

#SBATCH -p <partition>

#SBATCH -N <nodes>

#SBATCH --tasks=<number>

#SBATCH --cpus-per-task=<number>

#SBATCH --constraints=<node architecture> # sandy, ilk (icelake)... architecture

#SBATCH -t <days-HH:MM:SS>

#SBATCH -o <file.out>

#SBATCH -D .

#SBATCH --mail-user=<email_account>

#SBATCH --mail-type=BEGIN,END,FAIL,TIME_LIMIT_50,TIME_LIMIT_80,TIME_LIMIT_90

##########################################################

module purge

module load <modules>

srun <application>

Diferencia Entre los Parámetros de CPU#

--cpus-per-task: Especifica el número de CPUs (núcleos) que se asignarán a cada tarea. Se utiliza cuando una tarea requiere más de un CPU para funcionar, como en aplicaciones que pueden utilizar multihilo o paralelismo a nivel de hilo.

--ntasks: Define el número total de tareas que se ejecutarán en el trabajo. Cada tarea es una instancia separada del programa que estás ejecutando. Se usa principalmente para la paralelización a nivel de tareas, como en programas que utilizan MPI (Interfaz de Paso de Mensajes).

--ntasks-per-node: Determina cuántas tareas se ejecutarán en cada nodo. Esto es útil cuando se desea controlar cómo se distribuyen las tareas entre los nodos asignados. A menudo se usa en conjunto con ntasks para asegurar una distribución específica de tareas por nodo.

Ejemplo#

Objetivo#

Deseas ejecutar un total de 8 tareas de tu aplicación, donde cada tarea utilizará 4 núcleos. Quieres distribuir estas tareas en 2 nodos.

Script de Slurm#

Este script configura Slurm para ejecutar un programa que se beneficia de la paralelización tanto a nivel de tarea como a nivel de hilo:

#!/bin/bash

#SBATCH -J ejemplo_paralelismo

#SBATCH -p batch # Partición batch

#SBATCH -N 2 # Solicitando 2 nodos

#SBATCH --ntasks=8 # Total de 8 tareas a ejecutar

#SBATCH --ntasks-per-node=4 # Distribuir 4 tareas por nodo

#SBATCH --cpus-per-task=4 # Cada tarea utilizará 4 CPUs (núcleos)

#SBATCH --time=01:00:00 # Límite de tiempo de una hora

#SBATCH -o resultado_%j.out # Salida estándar

#SBATCH -e errores_%j.err # Errores estándar

module load mi_modulo # Cargar los módulos necesarios

srun mi_aplicacion # Ejecutar la aplicación

Explicación del Script#

--ntasks=8: Este parámetro establece que el trabajo consistirá en 8 tareas independientes. En el contexto de MPI, podrías pensar en esto como lanzar 8 procesos distintos.

--ntasks-per-node=4: Indica que cada nodo asignado al trabajo deberá ejecutar 4 de estas tareas. Dado que has solicitado 2 nodos y quieres ejecutar 8 tareas en total, cada nodo manejará 4 tareas.

--cpus-per-task=4: Especifica que cada tarea debe utilizar 4 núcleos. Esto es útil para tareas que pueden ejecutar hilos de manera concurrente, aprovechando la paralelización a nivel de hilo dentro de cada tarea.

Resultado Esperado#

Con esta configuración, el sistema de Slurm distribuirá el trabajo en los 2 nodos disponibles, colocando 4 tareas en cada uno, y cada tarea utilizará 4 núcleos de CPU en el nodo asignado. Esto puede resultar en un uso eficiente del hardware disponible, maximizando el rendimiento del programa que se beneficia tanto de la paralelización a nivel de tarea como de hilo.

Ejecutar un trabajo en la cola#

Normalmente, un trabajo es creado mediante un script de lanzamiento (shell script) donde las primeras líneas del archivo deben contener las directivas SBATCH así como la línea de comienzo #!/bin/bash que indica el interprete de shell a usar.

Mi primer trabajo con slurm#

En el siguiente ejemplo es un sencillo script que le ayude a familiarizarse con ellos.

Simplemente realiza la solicitud de recursos (particiones, nº de nodos, memoria, tiempo máximo de ejecución, directorios de trabajo, ficheros de salida,....),comienza con una ejecución de comandos linux básicos (steps) y espera 120 segundos antes de finalizar el trabajo.

#!/bin/bash

#SBATCH --job=mi_primer_test # Nombre del trabajo

#SBATCH --partition=batch # Partición (express/sbatch/long/fatnodes)

#SBATCH --nodes=1 # Nº de nodos

#SBATCH --mem=30000M # Memoria solicitada por nodo (30000M or 60000M)

#SBATCH --tasks-per-node=1 # Nº tareas por nodo

#SBATCH --constrains=sandy # sandy, ilk (icelake)... arquitecture

#SBATCH --time=02:00 # Límite de tiempo

#SBATCH --output=file_%j.log # Log de salida estandar

#SBATCH --error=file_%j.err # Log de salida errores

#SBATCH -D . # Directorio de trabajo

#SBATCH --mail-user=EMAIL # Donde será enviado el mail

#SBATCH --mail-type=END,FAIL # Eventos email

##########################################################

# UN COMENTARIO

echo "Comienza mi script"

pwd

hostname

date

sleep 120

echo "Finaliza mi script"

El mismo script se puede escribir con la opciónes corta:

#!/bin/bash

#SBATCH -J mi_primer_test # Nombre del trabajo

#SBATCH -p batch # Partición (express/sbatch/long/fatnodes)

#SBATCH -N 1 # Nº de nodos

#SBATCH --mem=30000M # Memoria solicitada por nodo (30000M or 60000M)

#SBATCH --tasks-per-node=1 # Nº tareas por nodo

#SBATCH --constrains=sandy # sandy, ilk (icelake)... arquitecture

#SBATCH -t 02:00 # Límite de tiempo

#SBATCH -o file%j.log # Log de salida

#SBATCH -e file_%j.err # Log de salida errores

#SBATCH -D . # Directorio de trabajo

#SBATCH --mail-user=EMAIL # Donde será enviado el mail

#SBATCH –mail-type=END,FAIL # Eventos email

##########################################################

# UN COMENTARIO

echo "Comienza mi script"

pwd

hostname

date

sleep 120

echo "Finaliza mi script"

Guarde el fichero creado anteriormente con un nombre apropiado en un directorio de trabajo creado para ello, por ejemplo mi_primer_test.sh o mi_primer_test.sbatch.

Info

Hay determinadas opciones que tienen valores ya establecidos por defecto, como es la partición, donde la partición por defecto es la batch.

Para ver todas las opciones disponibles sobre las directivas sbatch puede visitar la documentación oficial de slurm o ejecutando los siguientes comandos:

Como lanzar un job con sbatch#

Para lanzar el trabajo solo tiene que ejecutar el siguiente comando.

Mi segundo trabajo con slurm#

En este segundo ejemplo simplemente cargaremos una aplicación (module) para poder usarla. Concretamente un módulo de python y ejecutaremos un pequeño script de python.

Es recomendable crear un entorno virtual para ejecutar python (virtualenv, venv, pyenv, conda environment, pipenv). Por ejemplo para usar venv, en el directorio de trabajo ejecutar:

- Crear el script de lanzamiento:

#!/bin/bash

#SBATCH --job=mi_python_test # Nombre del trabajo

#SBATCH --nodes=1 # Nº de nodos

#SBATCH --constrains=sandy # sandy, ilk (icelake)... arquitecture

#SBATCH --time=02:00 # Límite de tiempo

#SBATCH --output=file_%j.log # Log de salida estandar

#SBATCH --error=file_%j.err # Log de salida errores

#SBATCH --chdir=. # Directorio de trabajo

#SBATCH --mail-user=email # Donde será enviado el mail

#SBATCH --mail-type=END,FAIL # Eventos email

##########################################################

# antes de cargar el módulo vemos si ha ejecutable de python3

echo "python3 antes:"; python3 --version

# Carga modulos

module purge

module load GCCcore/11.2.0 Python/3.8.6

echo "python3 despues"; python3 --version

which python3

echo "COMIENZA STEP1"

# Activo el entorno de python

source /path/workdir/venv/bin/activate

# Lanzamos el script de python

python3 hello_world.py

echo "FINALIZA MI SCRIPT"

Recuerde que su directorio de trabajo es ., que es el mismo directorio donde está script de ejecución y. Si hello_world.py está en otro directorio, debe especificar la ruta completa.

Otra opción es usar la variable de entorno de slurm* SLURM_SUBMIT_DIR. Para lanzar el trabajo:

Useful Slurm commands#

Slurm proporciona una variedad de herramientas que permiten al usuario administrar y comprender sus trabajos. Este tutorial presentará estas herramientas y proporcionará detalles sobre cómo usarlas.

Encontrar información en la cola de trabajo con squeue#

El comando squeue es una herramienta que usamos para obtener información sobre los trabajos que están en la cola. De manera predeterminada, el comando squeue imprimirá el ID del trabajo, la partición, el nombre del trabajo, el usuario del trabajo, el estado del trabajo, el tiempo que lleva en ejecución, la cantidad de nodos y la lista de nodos asignados:

squeue

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)

111111 batch my_job myuser R 1:21:59 1 node0101-1

Podemos generar información no abreviada con la marca --long. Esta bandera imprimirá la información predeterminada no abreviada con la adición de un campo de límite de tiempo:

El comando squeue también brinda a los usuarios un medio para calcular la hora de inicio estimada de un trabajo agregando el indicador --start a nuestro comando. Esto agregará la hora de inicio estimada de Slurm para cada trabajo en nuestra información de salida.

Nota

La hora de inicio proporcionada por este comando puede ser inexacta. Esto se debe a que la hora calculada se basa en los trabajos en cola o en ejecución en el sistema. Si un trabajo con una prioridad más alta se pone en cola después de ejecutar el comando, su trabajo puede ser demorado.

Al verificar el estado de un trabajo, es posible que desee llamar repetidamente al comando squeue para buscar actualizaciones. Podemos lograr esto agregando el indicador --iterate a nuestro comando squeue. Esto ejecutará squeue cada n segundos, lo que permite una actualización frecuente y continua de la información de la cola sin necesidad de llamar repetidamente a squeue:

Presione ctrl-c para detener el bucle del comando y regresar a la terminal.

Estado de los trabajos#

Una vez que se ha enviado un trabajo a una cola de trabajos, la ejecución seguirá estos estados:

PENDINGoPD: El trabajo ha entrado en la cola pero aún no están disponibles los recursos solicitados para que empieze a trabajar, es decir, que no haya nodos libres.RUNNINGoR: El trabajo se está ejecutando en la cola con los recursos que se han solicitado.COMPLETEDoCD: El trabajo se ha ejecutado correctamente, o al menos, lo que se ha especificado en el script de lanzamiento.COMPLETINGoCG: El trabajo está en proceso de terminar en un estado correcto.SUSPENDoS: la ejecución del trabajo se ha suspendido y los recursos utilizados se han liberado para otros trabajos.CANCELLEDoCA: el trabajo ha sido cancelado o por el usuario o por los administradores de sistemas.FAILEDoF: Ha fallado la ejecución del trabajo.NODE_FAILoNF: Ocurrió un error con el nodo y el trabajo no pudo lanzarse. Por defecto, Slurm relanza el trabajo de nuevo.

Razones de que un trabajo esté en PENDING#

Cuando un trabajo se encuntra en el estado de PENDING, se añade la razón de porqué está pendiente para ejecutar y ésta puede ser:

-

(Resources): el trabajo está esperando hasta que estén disponibles los recursos solicitados.

-

(Dependency): el trabajo es dependiente de otro y, por tanto, no entrará a ejecutar hasta que se cumpla la condición establecida para la dependencia.

-

(DependencyNeverSatisfied): El trabajo está esperando por una dependencia que no ha sido cumplida. El trabajo se quedara en este estado para siempre, por tanto, hay que cancelar el trabajo.

-

(AssocGrpCpuLimit): El trabajo no se puede ejecutar porque se ha consumido la cuota asignada de CPU.

-

(AssocGrpJobsLimit): El trabajo no se puede ejecutar porque se ha alcanzado el límite de trabajos simultáneos que tiene permitido ejecutar el usuario o la cuenta.

-

(ReqNodeNotAvail): El nodo especificado no está disponible. Puede ser que esté en uso, que esté resevado o puede que esté marcado como "fuera de servicio".

Info

Para obtener más información sobre squeue, visite la página de Slurm en squeue

Detener trabajos con scancel#

En ocasiones, es posible que deba detener un trabajo por completo mientras se está ejecutando. La mejor manera de lograr esto es con el comando scancel. Este comando permite cancelar los trabajos que está ejecutando en los recursos de Research Computing utilizando la ID del trabajo. El comando se ve así:

Para cancelar varios trabajos, puede usar una lista de ID de trabajos separados por comas:

Info

Para obtener más información, visite el manual de Slurm en scancel

Información de estado con sstat#

El comando sstat permite a los usuarios obtener fácilmente información sobre el estado de sus trabajos actualmente en ejecución. Esto incluye información sobre el uso de la CPU, información de la tarea, información del nodo, tamaño del conjunto residente (RSS) y memoria virtual (VM). Podemos invocar el comando sstat como tal:

Formatear la salida del sstat#

De forma predeterminada, sstat extraerá mucha más información de la que se necesitaría en la salida predeterminada de los comandos. Para remediar esto, podemos usar el indicador --format para elegir lo que queremos en nuestra salida. El indicador de formato toma una lista de variables separadas por comas que especifican los datos de salida:

Algunas de estas variables se enumeran en la siguiente tabla:

| Variable | Descripción |

|---|---|

| avecpu | Promedio de tiempo de CPU de todas las tareas en el trabajo. |

| averss | Tamaño medio del conjunto residente de todas las tareas. |

| avevmsize | Memoria virtual promedio de todas las tareas en un trabajo. |

| jobid | ID del trabajo. |

| maxrss | Número máximo de bytes leídos por todas las tareas del trabajo. |

| maxvsize | Número máximo de bytes escritos por todas las tareas en el trabajo. |

| ntasks | Número de tareas en un trabajo. |

Por ejemplo, imprima la identificación de trabajo promedio de un trabajo, el tiempo de CPU, el máximo de rss y la cantidad de tareas. Podemos hacer esto escribiendo el comando:

Info

Se puede encontrar una lista completa de variables que especifican datos manejados por sstat con el indicador --helpformat o visitando la página de slurm en sstat.

Analizar trabajos terminados con sacct#

El comando sacct permite a los usuarios obtener información sobre el estado de los trabajos terminados. Este comando es muy similar a sstat, pero se usa en trabajos que se ejecutaron previamente en el sistema en lugar de los trabajos que se están ejecutando actualmente. Podemos usar la identificación de un trabajo.

- Para todos los trabajos ejecutados:

- Para un único trabajo, identificado por su ID:

De forma predeterminada, sacct solo extraerá los trabajos que han ejecutado en el día en curso. Podemos usar el indicador --starttime para decirle al comando que mire más allá de su caché de trabajos a corto plazo.

Para ver una versión no abreviada de la salida de sacct, use el indicador --long:

Formatear la salida del sacct#

Al igual que sstat, es posible que la salida estándar no proporcione la información que queremos. Para remediar esto, podemos usar el indicador --format para elegir lo que queremos en nuestra salida. De manera similar, el indicador de formato es manejado por una lista de variables separadas por comas que especifican los datos de salida:

A continuación se proporciona una lista de algunas variables:

| Variable | Description |

|---|---|

| account | Cuenta con la que se ejecutó el trabajo |

| avecpu | Tiempo promedio de CPU de todas las tareas en el trabajo. |

| averss | Average resident set size of all tasks in the job. |

| cputime | Tiempo transcurrido de CPU usado por un job o paso |

| elapsed | Tiempo transcurrido de los trabajos con formato DD-HH:MM:SS |

| exitcode | El código de salida devuelto por el script de trabajo o salloc. |

| jobid | ID del trabajo. |

| jobname | Nombre del trabajo. |

| maxdiskread | Número máximo de bytes leidos por todas las tareas. |

| maxdiskwrite | Número máximo de bytes leidos por todas las tareas. |

| maxrss | El código de salida devuelto por el script de trabajo o salloc. |

| ncpus | Cantidad de CPU asignadas. |

| nnodes | Número de nodos usados. |

| ntasks | Número de tareas en un job. |

| priority | Prioridad Slurm. |

| qos | Calidad de servicio. |

| reqcpu | Número de CPUs solicitados |

| reqmem | Cantidad de memoria necesaria para un trabajo |

| user | Nombre de usuario de la persona que ejecutó el trabajo. |

Como ejemplo, suponga que desea buscar información sobre los trabajos que se ejecutaron el 12 de marzo de 2018. Desea mostrar información sobre el nombre del trabajo, la cantidad de nodos utilizados en el trabajo, la cantidad de CPU, el maxrss y el tiempo transcurrido. Su comando se vería así:

Como otro ejemplo, suponga que desea obtener información sobre los trabajos que se ejecutaron el 21 de febrero de 2018. Le gustaría obtener información sobre la identificación del trabajo, el nombre del trabajo, la calidad del servicio, la cantidad de nodos utilizados, la cantidad de CPU utilizadas, el RSS máximo y la CPU. tiempo, tiempo promedio de CPU y tiempo transcurrido. Su comando se vería así:

Info

Se puede encontrar una lista completa de variables que especifican datos manejados por sacct con el indicador --helpformat o visitando la página de slurm en sacct.

Control de trabajos en cola y en ejecución mediante scontrol#

El comando scontrol proporciona a los usuarios un mayor control de sus trabajos ejecutados a través de Slurm. Esto incluye acciones como suspender un trabajo, detener la ejecución de un trabajo o extraer información detallada sobre el estado de los trabajos.

Para suspender un trabajo que se está ejecutando actualmente en el sistema, podemos usar scontrol con el comando suspender. Esto detendrá un trabajo en ejecución en su paso actual que se puede reanudar en un momento posterior. Podemos suspender un trabajo escribiendo el comando:

Para reanudar un trabajo en pausa, usamos scontrol con el comando reanudar:

Slurm también proporciona una utilidad para retener trabajos que están en cola en el sistema. Retener un trabajo colocará el trabajo en la prioridad más baja, efectivamente "reteniendo" el trabajo para que no se ejecute. Un trabajo solo se puede retener si está esperando que el sistema se ejecute. Usamos el comando de espera para poner un trabajo en estado de espera:

Luego podemos liberar un trabajo retenido usando el comando de release:

scontrol también puede proporcionar información sobre trabajos mediante el comando show job. La información proporcionada por este comando es bastante extensa y detallada, así que asegúrese de borrar la ventana de su terminal, recopilar cierta información del comando o canalizar la salida a un archivo de texto separado:

Streaming de salida a un archivo de texto#

Canalizar la salida a Grep y encontrar líneas que contengan la palabra "Tiempo"#

Variables de entorno de salida en SLURM#

Dentro de los script de ejecución se pueden invocar ciertas variables con las que podemos conocer cierta información de la ejecución dentro un script.

Documentación para variables de entono de slurm

Las más usadas son las siguiente:

| Variable | |

|---|---|

| SLURM_ARRAY_JOB_ID | Job array's master job ID number. |

| SLURM_JOB_ID | The ID of the job allocation. |

| SLURM_JOBID | New version for the ID of the job allocation |

| SLURM_JOB_DEPENDENCY | Set to value of the --dependency option |

| SLURM_JOB_NAME | Name of the job. |

| SLURM_JOB_NODELIST | List of nodes allocated to the job |

| SLURM_JOB_NUM_NODES | Total number of nodes in the job's resource allocation |

| SLURM_JOB_PARTITION | Name of the partition in which the job is running |

| SLURM_NODELIST | List of nodes allocated to the job |

| SLURM_SUBMIT_DIR | The directory from which sbatch was invoked |

Script para ver las variables de slurm.#

Ejecutando el siguiente script usted puede ver las variables nombradas en el apartado anterior:

#!/bin/bash

#SBATCH -J GNUParallel -o %x-%J.out

#SBATCH --time=00:10:00

#SBATCH --mem-per-cpu=2G

#SBATCH -n 16

#SBATCH -c 4

# SBATCH --ntasks-per-node=8

#SBATCH --constrains=<node arquitecture> # sandy, ilk (icelake)... arquitecture

date

echo "SUBMITTED ON: $SLURM_SUBMIT_HOST IP: $SLURM_LAUNCH_NODE_IPADDR DIR: $SLURM_SUBMIT_DIR NODES ALLOCATED: $SLURM_JOB_NODELIST"

echo "RUNNING ON: $(hostname) $SLURMD_NODENAME"

echo "JOB_ID: $SLURM_JOB_ID ARRAY_JOB_ID: $SLURM_ARRAY_JOB_ID"

echo "STEP: $SLURM_STEP_ID NODEID: $SLURM_NODEID LOCALID: $SLURM_LOCALID PROCID: $SLURM_PROCID"

echo "ARRAY_TASK_COUNT: $SLURM_ARRAY_TASK_COUNT ARRAY_TASK_ID: $SLURM_ARRAY_TASK_ID ARRAY_TASK_MAX: $SLURM_ARRAY_TASK_MAX ARRAY_TASK_MIN: $SLURM_ARRAY_TASK_MIN ARRAY_STEPSIZE: $SLURM_ARRAY_TASK_STEP"

echo "Args: $*"

sleep 10

Investigar un trabajo fallido#

No siempre los trabajos se ejecutan correctamente. Hay una lista de motivos por los que los trabajos o las aplicaciones se detienen o fallan. Las causas más comunes son:

- Exceder los límites de recursos solicitados, como la memoria o el tiempo límite, por ejemplo.

- Errores específicos del software.

- Errores en el procesamiento de los datos.

Nota

Es importante recopilar mensajes de error/salida ya sea escribiendo dicha información en la ubicación predeterminada o especificando ubicaciones específicas mediante las opciones --error/--output, por ejemplo, aunque esto dependerá de cada software.

Los mensajes de error y de salida son el punto de partida para investigar un error en el trabajo.

Exceder los límites de recursos#

Cada partición define límites máximos y predeterminados para el tiempo de ejecución y el uso de la memoria. Dentro de la especificación del trabajo, los límites actuales se pueden definir dentro de los rangos. Para una mejor programación, se deben estimar los requisitos del trabajo y adaptar los límites a las necesidades. Cuanto más bajos sean los límites mejor, así SLURM podrá encontrar un lugar. Además, cuanto menos gastos generales de recursos se especifican, menos recursos se desperdician, como por ejemplo, con la memoria.

Info

Si un trabajo excede el tiempo de ejecución o el límite de memoria, SLURM matará el trabajo.

Información de error#

En ambos casos, el archivo de errores proporciona información adecuada:

- Tiempo límite:

(...)

slurmstepd: error: *** JOB 41239 ON fnode01 CANCELLED AT 2016-11-30T11:22:57 DUE TO TIME LIMIT ***

(...)

- Límite de memoria:

(...)

slurmstepd: error: Job 41176 exceeded memory limit (3940736 > 2068480), being killed

slurmstepd: error: Exceeded job memory limit

slurmstepd: error: *** JOB 41176 ON fnode01 CANCELLED AT 2016-11-30T10:21:37 ***

(...)

Errores de Software#

Slurm captura el código de salida de un trabajo y lo guarda como parte del registro del trabajo. Para trabajos lanzados con sbatch, se captura el código de salida del script. Para trabajos lanzados con srun, el código de salida será el valor de retorno del comando ejecutado. Cualquier código de salida distinto de cero se considera un error de trabajo y da como resultado un estado de trabajo de FAILED.

Si una señal es responsable de la terminación de un trabajo/paso, el número de la señal también se capturará y se mostrará después del código de salida (separado por dos puntos).

Según el orden de ejecución de los comandos en el script sbatch, es posible que un comando específico falle, pero el script por lotes devolverá cero, lo que indica que se realizó correctamente. Por ejemplo:

#!/bin/bash

#SBATCH --job=my_r_test # Nombre del trabajo

#SBATCH --nodes=1 # Nº de nodos

#SBATCH --constrains=sandy # sandy, ilk (icelake)... arquitecture

#SBATCH --time=02:00 # Límite de tiempo

#SBATCH --output=file_%j.log # Log de salida estandar

#SBATCH --error=file_%j.err # Log de salida errores

#SBATCH --chdir=. # Directorio de trabajo

#SBATCH --mail-user=email # Donde será enviado el mail

#SBATCH --mail-type=END,FAIL # Eventos email

##########################################################

Rscript fail.R

echo "Script finished"

El código de salida y el estado indican incorrectamente que el trabajo finalizó correctamente:

sbatch job_sbatch.sh

Submitted batch job 41585

sacct -j 41585

JobID JobName Partition Account AllocCPUS State ExitCode

------------ ---------- ---------- ---------- ---------- ---------- --------

41585 Simple E + all id 1 COMPLETED 0:0

41585.batch batch id 1 COMPLETED 0:0

Solo el archivo de salida específico de R muestra el error:

Puede evitar este problema "saliendo" con un código de salida adecuado tan pronto como falle el comando:

#!/bin/bash

#SBATCH --job=my_r_test # Nombre del trabajo

#SBATCH --nodes=1 # Nº de nodos

#SBATCH --constrains=sandy # sandy, ilk (icelake)... arquitecture

#SBATCH --time=02:00 # Límite de tiempo

#SBATCH --output=file_%j.log # Log de salida estandar

#SBATCH --error=file_%j.err # Log de salida errores

#SBATCH --chdir=. # Directorio de trabajo

#SBATCH --mail-user=email # Donde será enviado el mail

#SBATCH --mail-type=END,FAIL # Eventos email

##########################################################

Rscript fail.R || exit 91

echo "Script finished"

Ahora, el código de salida y el estado coinciden con el verdadero resultado:

sbatch job_sbatch.sh

Submitted batch job 41925

sacct -j 41925

JobID JobName Partition Account AllocCPUS State ExitCode

------------ ---------- ---------- ---------- ---------- ---------- --------

41925 Simple E + all id 1 FAILED 91:0

41925.batch batch id 1 FAILED 91:0

Compruebe siempre los archivos de salida específicos de la aplicación en busca de mensajes de error.

Límites de memoria Slurm#

Slurm impone un límite de memoria en cada trabajo. De forma predeterminada, es deliberadamente relativamente pequeño: 2 GB por nodo. Si su trabajo usa más que eso, recibirá un error que indica que su trabajo ha excedido la memoria solicitada (Exceeded job memory limit).

Para establecer un límite mayor, agregue a su envío de trabajo:

donde X es la cantidad máxima de memoria que usará su trabajo por nodo, en MB.

Cuanto mayor sea su conjunto de datos de trabajo, mayor deberá ser, pero cuanto menor sea el número, más fácil será para slurm encontrar un lugar para ejecutar su trabajo.

Para determinar un valor apropiado, consulte siguiente sección.

Cómo estudiar la eficiencia de un job#

Muchas veces nos preguntamos cómo puedo saber qué tan eficiente es mi trabajo y para ello tenemos el comando seff.

donde el JOBID es el id del trabajo en el que estás interesado. Por ejemplo:

$ seff 1553

Job ID: 1553

Cluster: teide

User/Group: viddata/viddata

State: COMPLETED (exit code 0)

Nodes: 4

Cores per node: 16

CPU Utilized: 2-11:55:56

CPU Efficiency: 89.73% of 2-18:47:28 core-walltime

Job Wall-clock time: 01:02:37

Memory Utilized: 26.08 GB (estimated maximum)

Memory Efficiency: 23.85% of 109.38 GB (27.34 GB/node)

Solicite memoria un poco mayor a lo que seff dice.

Debe configurar la memoria que solicita en algo un poco más grande que lo que dice seff.

seff informa del máximo de memoria usada en jobs paralelos.

Tenga en cuenta que para trabajos paralelos que abarcan varios nodos, esta es la memoria máxima utilizada en cualquier nodo; si no está configurando una distribución uniforme de tareas por nodo (por ejemplo, con --ntasks-per-node), el mismo trabajo podría tener valores muy diferentes cuando se ejecuta en diferentes momentos.

Espera a que el trabajo termine satisfactoriamente.

También tenga en cuenta que el número registrado por slurm para el uso de la memoria será inexacto si el trabajo finalizó de forma no satisfactoria. Para obtener una medición precisa, debe tener un trabajo que se complete correctamente, ya que slurm registrará el pico de memoria real.

Memoria máxima por tipo de nodo#

| Tipo de nodo | Solicitud máxima de memoria en slurm | |

|---|---|---|

| Sandy bridge 16 Cores - 32 GB | 30000 MB | |

| Sandy bridge 16 Cores - 64 GB | 62000 MB | |

| Fat Nodes 32 Cores - 256 GB | 254000 MB | bajo solicitud |

| Icelake Nodos GPU 64 Cores - 256 GB | 254000 MB | bajo solicitud |

¿Cómo puedo saber qué tan eficiente es mi trabajo?#

Puede ver la eficiencia de su trabajo comparando MaxRSS, MaxVMSize, Elapsed, CPUTime, NCPUS con el comando sacct.

sacct -j 999997 --format=User,JobID,Jobname%25,partition,elapsed,MaxRss,MaxVMSize,nnodes,ncpus,nodelist%20

User JobID JobName Partition Elapsed MaxRSS MaxVMSize NNodes NCPUS NodeList

--------- ------------ ----------------- ---------- ---------- ---------- ---------- -------- ---------- --------------------

eolicase 999996 WRF_2023080618 batch 13:32:47 4 64 node1511-[1-4]

999996.batch batch 13:32:47 216700K 815628K 1 16 node1511-1

999996.0 geogrid.exe 00:00:57 236240K 2762564K 4 8 node1511-[1-4]

999996.1 metgrid.exe 00:01:54 15395M 591912K 4 4 node1511-[1-4]

999996.2 real.exe 00:00:26 338148K 2928876K 4 16 node1511-[1-4]

999996.3 wrf.exe 13:26:36 598864K 3768748K 4 64 node1511-[1-4]

En este trabajo, ve que el usuario usó 64 núcleos y su trabajo se ejecutó durante 13,5 horas. Sin embargo, su tiempo de CPU es de 13,5 horas, que está cerca de las 64*13 horas. Si su código escala efectivamente según esta fórmula CPUTime = NCPUS * Elapsed su aplicación escala perfectamente. Si no lo es, el resultado divergirá de la fórmula y la mejor manera de probar esto y determinar cómo escala la aplicación es hacer algunas pruebas de escala.

Hay dos formas de hacer esto: Strong scaling (escalado fuerte) and Weak scaling (escalado débil).

Strong scaling (Escalado fuerte)#

El escalado fuerte es donde deja el tamaño del problema igual pero aumenta la cantidad de núcleos. Si su código se escala bien, debería tomar menos tiempo proporcional a la cantidad de núcleos que usa.

Weak scaling (escalado débil)#

La cantidad de trabajo por núcleo sigue siendo la misma, pero aumenta la cantidad de núcleos, por lo que el tamaño del trabajo se escala proporcionalmente a la cantidad de núcleos. Por lo tanto, si su código se escala en este caso, el tiempo de ejecución debería seguir siendo el mismo.

Por lo general, la mayoría de los códigos tienen un punto en el que la escala se rompe debido a ineficiencias en el código.

Por lo tanto, más allá de ese punto, no hay ningún beneficio en aumentar la cantidad de núcleos que arroja al problema. Ese es el punto que quieres buscar. Esto se ve más fácilmente trazando el registro de la cantidad de núcleos frente al registro del tiempo de ejecución.

Consejos de uso#

Tip: Reservar nodos de computo completos

En los nodos de cómputo se recomienda reservar nodos completos utilizando la opción -N <nodes\>, para que no interfieran ejecuciones de otros usuarios entre sí. Recuerde que la facturación de estos nodos es por uso de nodo.

Tip: Enviar un trabajo con sbatch

Es aconsejable el enviar el trabajo mediante sbatch así como los el uso de los modificadores -D <directorio\> y -t <tiempo\>.

Tip: Número de tareas por nodo

Es posible realizar ejecuciones sin utilizar todos los cores disponibles en el nodo. Para ello sólo hay que solicitar el número de nodos mediante -N X y el número de procesos a ejecutar en cada nodo con --tasks-per-node:

Tip: Notificaciones del gestor de trabajos slurm

Es posible gestionar la notificación automática de ciertos eventos del trabajo con las siguientes directivas.

#SBATCH --mail-user=EMAIL # Email de notificación de eventos

#SBATCH --mail-type=EVENT1,EVENT2,... # Eventos notificables

- Aclaración sobre los eventos por correo de Slurm:

Slurm puede enviar correos a la dirección especificada sobre una serie de eventos que le ocurran al trabajo. Dichos eventos pueden ser:

- BEGIN: cuando el trabajo entra en ejecución.

- END: cuando la ejecución del trabajo finalizada.

- FAIL: cuando la ejecución del trabajo falla.

- TIME_LIMIT: cuando el trabajo alcanza el tiempo máximo de ejecución.

- TIME_LIMIT_50: cuando el trabajo haya alcanzado el 50% del tiempo límite.

- TIME_LIMIT_80: cuando el trabajo haya alcanzado el 80% del tiempo límite.

- TIME_LIMIT_90: cuando el trabajo haya alcanzado el 90% del tiempo límite.

- ARRAY_TASKS: envía una notificación por email por cada trabajo del array. Si, al usar arrays, no se especifica esta opción, se enviará un email como si fuera un único trabajo.

- ALL: todos los tipos de eventos.

De todos los eventos posibles, recomendamos que se utilicen los relacionados con el consumo de tiempo límite permitido, TIME_LIMIT_50, TIME_LIMIT_80 y TIME_LIMIT_90. De esta forma, el usuario es consiente del tiempo que le queda al trabajo y, si fuese necesario, puede enviar a tiempo un correo a los administradores para que se le amplíe el tiempo de ejecución al trabajo.

Ended: Gestión de trabajos

Temas avanzados ↵

Ejecuciones secuenciales#

La unidad de reserva mínima para ejecutar en TeideHPC es el nodo, por lo que, independientemente del trabajo a ejecutar, a la hora de realizar el accounting del mismo, se considerará que se ha hecho uso de nodos completos. Es decir, el cómputo de horas de uso de la infraestructura viene dado por el número de horas que cada nodo está ejecutando el trabajo en cuestión, se use o no todos los recursos disponibles del mismo.

Para que el usuario no se vea perjudicado por este hecho, habrá de estructurar sus ejecuciones de manera que pueda agruparlas en igual cantidad de número de cores al de los nodos (16).

Las ejecuciones secuenciales suelen requerir muchas ejecuciones de trabajos a pocos cores, por lo que el usuario deberá estructurar los datos de entrada para las ejecuciones en carpetas o nombres de ficheros identificados mediante un número de trabajo, de manera que éste se pueda manipular de manera sencilla dentro del script de lanzamiento.

Una vez se tengan los datos de entradas organizados de esta manera se puede proceder a la ejecución de la misma, lanzando en un script de submit tantas tareas como quepan en un nodo.

Ejemplo de ejecución sequencial de trabajos de 1 core#

El siguiente script de ejemplo lanza 16 trabajos de 1 core simultáneamente.

# !/bin/bash

#SBATCH -J <job_name>

#SBATCH -p <partition>

#SBATCH -N 1

#SBATCH --constrains=<node arquitecture> # sandy, ilk (icelake)... arquitecture

#SBATCH -t <days-HH:MM:SS>

#SBATCH -o <file.out>

#SBATCH -D .

##########################################################

module purge

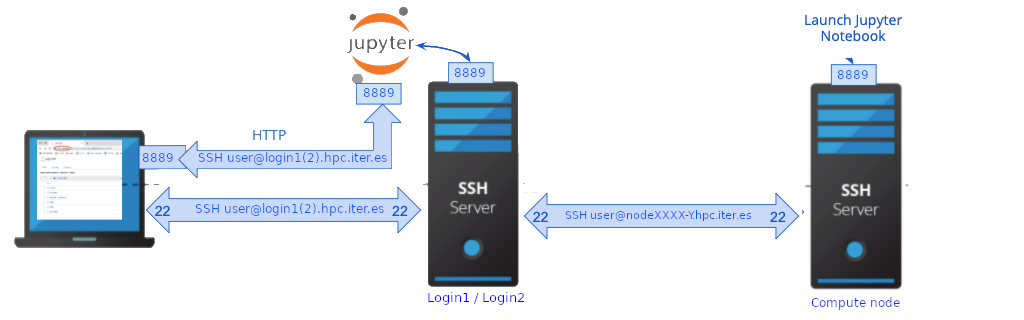

module load <modules>